권호기사보기

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 대표형(전거형, Authority) | 생물정보 | 이형(異形, Variant) | 소속 | 직위 | 직업 | 활동분야 | 주기 | 서지 | |

|---|---|---|---|---|---|---|---|---|---|

| 연구/단체명을 입력해주세요. | |||||||||

|

|

|

|

|

|

* 주제를 선택하시면 검색 상세로 이동합니다.

표제지

목차

Abstract 6

Ⅰ. 서론 9

1. 연구의 배경 및 목적 9

2. 연구의 구성 11

Ⅱ. 이론적 배경 12

1. 선행 연구 12

(1) 기계학습(Machine Learning) 기반의 텍스트 분류 12

(2) 딥러닝(Deep Learning) 기반의 텍스트 분류 13

2. 데이터마이닝(Data Mining) 15

Ⅲ. 연구 방법 17

1. 텍스트 처리 방법(Text Preprocessing Method) 17

(1) 형태소(morpheme) 분석 17

(2) 불용어(Stopword) 처리 17

(3) 텍스트 벡터화(Text Vectorization) 19

2. 딥러닝(Deep Learning) 20

(1) 인공신경망(artificial neural network) 20

(2) 순환신경망(RNN, Recurrent Neural Network) 22

(3) LSTM(Long Short-Term Memory) 24

Ⅳ. 데이터 설명 및 전처리 26

1. 데이터 설명 26

(1) 데이터 수집 26

(2) 데이터 기초분석 27

2. 데이터 전처리 29

(1) 카테고리 재분류(Category Reclassification) 29

(2) 문장 분리(Sentence Separation) 31

(3) 텍스트 전처리(text preprocessing) 33

(4) 형태소 분석(Morpheme Analysis) 34

(5) 불용어 처리(Stopword Removal) 35

(6) 토큰화(Tokenization) 38

(7) 학습셋(Training Set) 구축 39

Ⅴ. 분석 결과 40

1. 전체 프로세스 40

2. 1단계 : RNN 기반의 문장 범주 예측 41

(1) RNN 모델 설계 41

(2) 하이퍼 파라미터의 변화에 따른 성능 비교 43

(3) RNN 기반의 문장 단위 범주 예측 모델 활용 52

3. 2단계 : LSTM 기반의 게시글 범주 예측 56

(1) LSTM 모델의 설계 56

(2) 모델 소개 57

(3) 모델의 성능 평가 60

(4) 결과 64

Ⅵ. 결론 및 한계 65

1. 연구 요약 65

2. 시사점 및 한계 66

참고문헌 67

〈그림 1〉 텍스트마이닝의 종류 16

〈그림 2〉 인공신경망의 예 20

〈그림 3〉 RNN의 구조 22

〈그림 4〉 RNN의 설계구조 23

〈그림 5〉 LSTM 네트워크 구조 24

〈그림 6〉 LSTM 프로세스 25

〈그림 7〉 월 단위 게시글 수 27

〈그림 8〉 TF-IDF 결과를 변환하는 과정 36

〈그림 9〉 No-Meaning Rate 계산 과정 37

〈그림 10〉 RNN-LSTM 2단계 텍스트 분류 모델 전체 프로세스 40

〈그림 11〉 RNN 기반의 문장 범주 예측 모델 도식화 41

〈그림 12〉 Max length가 10일 때의 Loss 그래프(x축 : Epoch, y축 : Loss) 46

〈그림 13〉 Embedding dim이 50일 때의 Loss 그래프(x축 : Epoch, y축 : Loss) 48

〈그림 14〉 Embedding dim이 30일 때의 Loss 그래프 48

〈그림 15〉 Unit이 4, 8, 16일 때의 Loss 그래프 50

〈그림 16〉 Unit이 32일 때의 Loss 그래프 50

〈그림 17〉 '의미없음' 문장 제거 처리결과 예시 52

〈그림 18〉 카테고리별 가중치(W) 적용 프로세스 설명 55

〈그림 19〉 LSTM 기반의 게시글 범주 예측 모델 도식화 56

〈그림 20〉 Model 별 분석 프로세스 비교 59

Text classification is a task where text like a word, a sentence, and a paragraph is classified by category, and it is one of the unstructured data analysis.

Many researchers have attempted to solve the text classification problem using deep learning. In particular, LSTM, that is designed for the past events to influence the future outcomes, was suitable for approaching text classification problems. However, LSTM has a limitation where the performance decreased as time steps number, the number of average words used, increased. This is because people also write meaningless sentences that don't address the purpose of the article, apart from the problems of long-term dependencies.

To solve these problems, this research proposed 'text classification model using RNN-LSTM two-step with sentences-reflecting learning results'. This model improved the classification accuracy of long documents by proceeding sentence-level learning with RNN, and then reflecting the result, and then applying it to LSTM again.*표시는 필수 입력사항입니다.

| *전화번호 | ※ '-' 없이 휴대폰번호를 입력하세요 |

|---|

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 번호 | 발행일자 | 권호명 | 제본정보 | 자료실 | 원문 | 신청 페이지 |

|---|

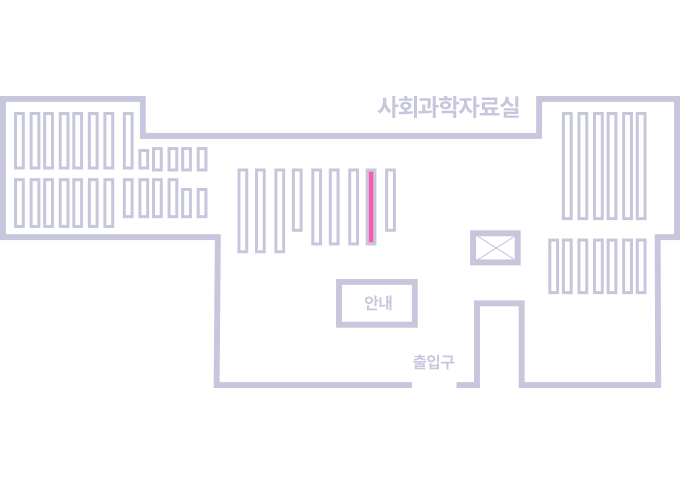

도서위치안내: / 서가번호:

우편복사 목록담기를 완료하였습니다.

*표시는 필수 입력사항입니다.

저장 되었습니다.