권호기사보기

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 대표형(전거형, Authority) | 생물정보 | 이형(異形, Variant) | 소속 | 직위 | 직업 | 활동분야 | 주기 | 서지 | |

|---|---|---|---|---|---|---|---|---|---|

| 연구/단체명을 입력해주세요. | |||||||||

|

|

|

|

|

|

* 주제를 선택하시면 검색 상세로 이동합니다.

표제지

목차

요약 10

ABSTRACT 11

1. 서론 13

2. 관련연구 15

2.1. Time Series Classification 15

2.2. Transformer-based Language Model 16

3. 배경이론 17

3.1. Imaging of time series 17

3.2. Transformer 18

3.3. Self-supervised learning 21

4. 데이터 셋 및 모델 24

4.1. Univariate Time Series dataset 24

4.2. Embedding Method 26

4.3. Pre-training Method 30

4.4. Fine-tuning Method 31

5. 실험 결과 33

5.1. 실험 환경 및 방법 33

5.2. 성능 비교 35

5.3. Ablation Study 36

5.3.1. Pre-training 유/무에 따른 성능 비교 36

5.3.2. 입력 데이터의 scaling에 따른 성능 비교 37

5.3.3. Time window의 embedding 방법에 따른 성능 비교 39

5.3.4. Pooling 방법에 따른 성능 비교 40

5.3.5. CLS 토큰 생성 방식에 따른 성능 비교 41

5.3.6. Attention Map visualization 및 분석 42

5.3.7. 제안 모델의 Robustness 분석 57

6. 결론 및 향후 계획 61

7. 참고문헌 62

그림 1. (a)는 gun point 데이터에서 하나의 데이터를 plotting한 결과. (b)는 (a)의 데이터를 Recurrence plot을 이용하여 이미지화한 결과. 17

그림 2. (a)는 gun point 데이터에서 하나의 데이터를 plotting한 결과. (b)는 GASF 수식을 이용한 결과. (c) GADF 수식을 이용한 결과. 18

그림 3. Transformer 모델 구조 19

그림 4. Positional encoding 값의 Euclidean distance map 20

그림 5. Self-Attention Mechanism 21

그림 6. Pretext task 22

그림 7. Contrastive learning 22

그림 8. Time window 계산 방식 27

그림 9. Time window Embedding 27

그림 10. Layer Normalization에 따른 입력 데이터 분포 29

그림 11. Pre-training 모델 30

그림 12. Fine-tuning 모델 31

그림 13. 평균 Ranking 비교 36

그림 14. Scaler에 따른 데이터 변환 38

그림 15. CLS 토큰 사용 안했을 시 layer1(데이터1) 44

그림 16. CLS 토큰 사용 안했을 시 layer2(데이터1) 45

그림 17. CLS 토큰 MLP로 사용 layer1(데이터1) 46

그림 18. CLS 토큰 MLP로 사용 layer2(데이터1) 47

그림 19. CLS 토큰 Random으로 사용 layer1(데이터1) 48

그림 20. CLS 토큰 Random으로 사용 layer2(데이터1) 49

그림 21. CLS 토큰 Random으로 사용 layer1(데이터2) 50

그림 22. CLS 토큰 Random으로 사용 layer2(데이터2) 51

그림 23. 그림 15-22까지의 attention을 실제 데이터에 강조 표시한 결과 52

그림 24. CLS 토큰 ResNet으로 사용 layer1(데이터1) 54

그림 25. CLS 토큰 ResNet으로 사용 layer2(데이터1) 55

그림 26. Head별 CLS→CLS, Others→CLS Attention의 평균값 56

그림 27. DiatomSizeReduction 데이터 57

그림 28. LargeKitchenAppliances 데이터 58

그림 29. Cricket_Y 데이터 59

그림 30. InsectWingbeatSound 데이터 59

시계열 데이터란 일정한 시간 동안 수집된 일련의 순차적으로 정해진 데이터셋의 집합을 의미하며 예측, 분류, 이상치 탐지 등에 활용되고 있다. 기존의 시계열 분야의 인공지능 모델에는 RNN(Recurrent Neural Network)을 주로 활용하여 분석을 진행했지만, 최근 Transformer 모델의 개발로 인하여 연구 추세가 변화하고 있다. Transformer 모델은 시계열 데이터 예측에는 좋은 성능을 보이지만, 분류 쪽에서는 상대적으로 부족한 성능을 보인다. 본 논문에서는 시계열 분류를 위한 Transformer 모델에 CLS 토큰을 추가하여 성능 향상에 초점을 맞추었다. 본 논문에서 제안하는 방식은 1) 입력 데이터의 임베딩 방법, 2) 사전 학습 방법이다. 1) 입력 데이터의 임베딩 방법은 총 2가지 방법을 이용한다. 첫 번째는 입력 데이터를 standard scaler를 활용하여 각기 다른 진폭을 가지는 시계열 데이터들을 정규화하여 진폭을 균일하게 만들고 time window 방식으로 데이터의 차원을 변경한 뒤 GRU(Gated Recurrent Unit)를 통하여 Transformer에 입력 토큰으로 활용한다. 두 번째는 GASF(Gramian Angular Summation Field)를 활용하여 입력 데이터를 이미지로 만든 뒤 사전 학습된 컴퓨터 비전 모델을 활용하여 얻어낸 벡터를 Transformer의 CLS 토큰 입력으로 활용한다.

사전 학습 방식은 자연어 분야에서 사용하는 MLM(Masked Language Modeling)과 유사한 방식을 활용한다. 시계열 데이터는 자연어와 다르게 연속 변수로 이루어져 있어서 목적함수 계산 시 MSE(Mean Squared Error)를 활용한다. 입력 토큰의 마스킹 작업 시에 CLS 토큰은 제외하고 나머지 입력 토큰 중 30%를 마스킹하고 마스킹 된 값을 출력단에서 맞추는 형식으로 학습된다. 본 논문에서는 UCR 데이터 셋을 활용하여 총 12개의 서로 다른 모델들과 제안하는 모델의 성능을 비교한다. 제안하는 모델은 85개의 데이터에 대한 평균 정확도 평가에서 최소 1.4% 최대 21.1%까지 성능 향상을 보였다.*표시는 필수 입력사항입니다.

| *전화번호 | ※ '-' 없이 휴대폰번호를 입력하세요 |

|---|

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 번호 | 발행일자 | 권호명 | 제본정보 | 자료실 | 원문 | 신청 페이지 |

|---|

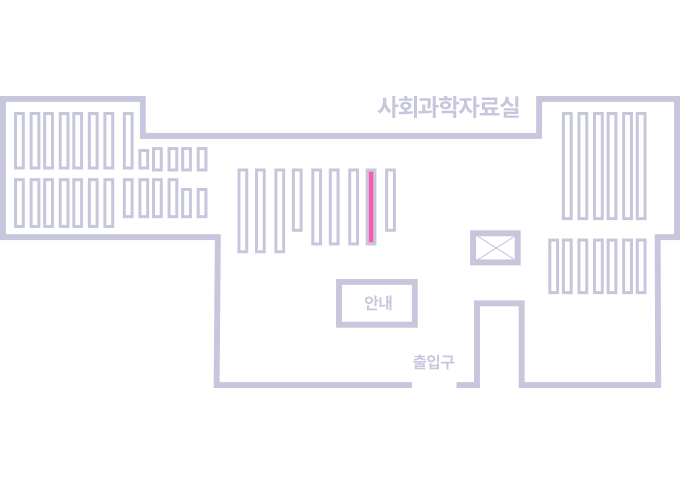

도서위치안내: / 서가번호:

우편복사 목록담기를 완료하였습니다.

*표시는 필수 입력사항입니다.

저장 되었습니다.