권호기사보기

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 대표형(전거형, Authority) | 생물정보 | 이형(異形, Variant) | 소속 | 직위 | 직업 | 활동분야 | 주기 | 서지 | |

|---|---|---|---|---|---|---|---|---|---|

| 연구/단체명을 입력해주세요. | |||||||||

|

|

|

|

|

|

* 주제를 선택하시면 검색 상세로 이동합니다.

Title Page

ABSTRACT

Contents

Ⅰ. Introduction 10

Ⅱ. Background and Related Work 15

1. Autoscaling mechanism of Kubernetes 15

2. Knative runtime and its auto-scaler 18

Ⅲ. Benchmarking Overview 21

1. Aim and Scope 21

2. Custom metrics related to autoscaling 23

3. Benchmark suites and workload specification 25

Ⅳ. Evaluation and Implications 28

1. Correlation between auto-scaling and the initial resource allocation of pods 30

2. Auto-scaling efficiency depending on scaling threshold 40

3. Auto-scaling behavior of HPA depending on base resource metrics 47

Ⅴ. Selecting a default autoscaling policy: HPA vs KPA 53

1. Comparison of auto scaling performances in HPA and KPA with their default metrics 53

2. Miscellaneous : FaaS deployment breakdown 59

Ⅵ. Conclusion 62

References 63

논문 개요 70

TABLE 1. Detailed specification of deployed functions 27

TABLE 2. Knative's key process to ready a pod 60

FIGURE 1. Typical FaaS architecture and system components utilizing Knative on Kubernetes 18

FIGURE 2. An overview of FaaS environmental setup for function deployment and invocation 25

FIGURE 3. (a) Comparison of the scaling process with different threshold settings (b) Comparison of the Number of [200] responses (c)... 31

FIGURE 4. (a) Comparison of the scaling process with different initial pod resource settings (b)Comparison of the Number of [200] responses... 35

FIGURE 5. (a) Comparison of the scaling process with different threshold settings (b) Comparison of the Number of [200] responses (c)... 43

FIGURE 6. (a) Comparison of the scaling process (b) Comparison of the Number of [200] responses (c) comparison of the overall latency distribution 49

FIGURE 7. (a) Concurrency level of 80 (b) Concurrency level of 600 55

FIGURE 8. (a) Trends in response according to concurrency level(1~100) (b) Trends in SLA of HPA (c) Trends in SLA of KPA 58

FIGURE 9. (a) Trends in response according to concurrency level(100~600) (b) Trends in SLA of HPA (c) Trends in SLA of KPA 58

FIGURE 10. Time spent on pod ready process 61

최근 서버리스 컴퓨팅 기술의 혁신으로 클라우드 네이티브 애플리케이션을 쉽고 유연하게 관리할 수 있게 되었다. 이러한 서버리스 아키텍처를 활용하는 다양한 패러다임 중 하나인 Function-as-a-Service(FaaS) 컴퓨팅 모델을 통해 개발자는 비용 효율적으로 컴퓨터화된 서비스의 핵심 논리에 더 집중할 수 있게 되었다. 이 때 인프라 관리 문제를 해결하려는 개발자의 요구를 수용하기 위해 Managed Service Provider(MSP)는 자동 확장 기능을 갖춘 컨테이너 조정 역할을 수행한다. 일반적으로 FaaS 플랫폼은 컨테이너 오케스트레이션 및 Knative와 같은 런타임 환경을 제공하는 서버리스 백엔드 솔루션을 사용하여 컨테이너화된 서비스에 대한 리소스 관리 기능을 활용한다. 그러나 관련된 지침의 부족과 자동 확장 구성 옵션의 다양성 때문에 MSP는 다양한 클라이언트의 Service Level Objectives(SLO)를 충족하는 데 어려움을 겪고 있다. 본 논문은 쿠버네티스의 자동 스케일링과 FaaS 워크로드 성능 간의 관계를 탐구하고 최첨단 자동 스케일링 도구인 HPA 및 KPA를 사용하여 적절한 자동 스케일링 로직을 설정하는 방법을 시연하기 위한 측정 연구를 수행한다.

*표시는 필수 입력사항입니다.

| *전화번호 | ※ '-' 없이 휴대폰번호를 입력하세요 |

|---|

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 번호 | 발행일자 | 권호명 | 제본정보 | 자료실 | 원문 | 신청 페이지 |

|---|

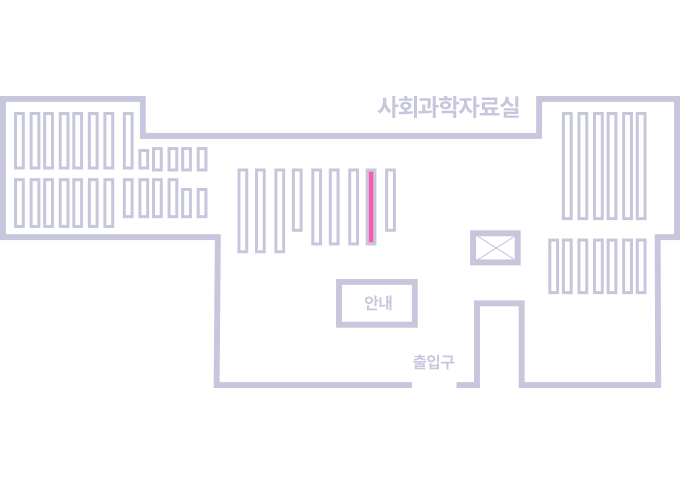

도서위치안내: / 서가번호:

우편복사 목록담기를 완료하였습니다.

*표시는 필수 입력사항입니다.

저장 되었습니다.