권호기사보기

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 대표형(전거형, Authority) | 생물정보 | 이형(異形, Variant) | 소속 | 직위 | 직업 | 활동분야 | 주기 | 서지 | |

|---|---|---|---|---|---|---|---|---|---|

| 연구/단체명을 입력해주세요. | |||||||||

|

|

|

|

|

|

* 주제를 선택하시면 검색 상세로 이동합니다.

표제지

국문초록

목차

Ⅰ. 서론 10

1.1. 녹내장 개요 10

1.2. 연구의 필요성 15

Ⅱ. 관련 연구 16

2.1. 멀티모달 분류 모델 16

2.2. 멀티모달 녹내장 진단 모델들 19

2.3. 정형데이터의 이미지 변환 연구 21

Ⅲ. 실험 방법 24

3.1. 제안한 방법 소개 24

3.1.1. 안저사진 처리 25

3.1.2. EMR 데이터 처리 25

3.1.3. 데이터 통합 및 모델 구축 25

3.2. 실험 절차 26

3.2.1. 데이터셋 26

3.2.2. 안저사진 처리 27

3.2.3. EMR 데이터 전처리 28

3.2.4. EMR 데이터 정규화 29

3.2.5. 정형데이터의 이미지 변환 30

3.2.6. 데이터 통합 및 모델 구축 35

3.3. 실험 환경 37

3.4. 평가 지표 38

3.5. 비교 대상 모델 40

3.5.1. 싱글모달 비교모델 40

3.5.2. 멀티모달 비교모델 42

Ⅳ. 실험 결과 43

4.1. 제안모델의 성능 평가 43

4.2. 제안모델과 이전 모델의 성능 비교 45

Ⅴ. 결론 47

참고문헌 48

부록 52

Abstract 56

Figure 1-1. OCT Sample 11

Figure 1-2. Visual Field Test Sample 12

Figure 1-3. Fundus Image Sample 13

Figure 1-4. EMR data Sample 14

Figure 2-1. Early Fusion Architecture Example 17

Figure 2-2. Late Fusion Architecture Example 17

Figure 2-3. Cross-modality Fusion Architecture Example 18

Figure 2-4. Feature Vector to Pixel via DeepInsight 21

Figure 2-5. Numeric Data Visualization with Brightness Variation 22

Figure 2-6. Time-series Data Visualization with Line Plot 23

Figure 3-1. Overview of the Multimodal Structure 24

Figure 3-2. Fundus Image Preprocessing 27

Figure 3-3. Feature Layout and Color in Image 30

Figure 3-4. Numeric to Image Conversion Example 34

Figure 3-5. Multimodal Data Integration Structure 35

*표시는 필수 입력사항입니다.

| *전화번호 | ※ '-' 없이 휴대폰번호를 입력하세요 |

|---|

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 번호 | 발행일자 | 권호명 | 제본정보 | 자료실 | 원문 | 신청 페이지 |

|---|

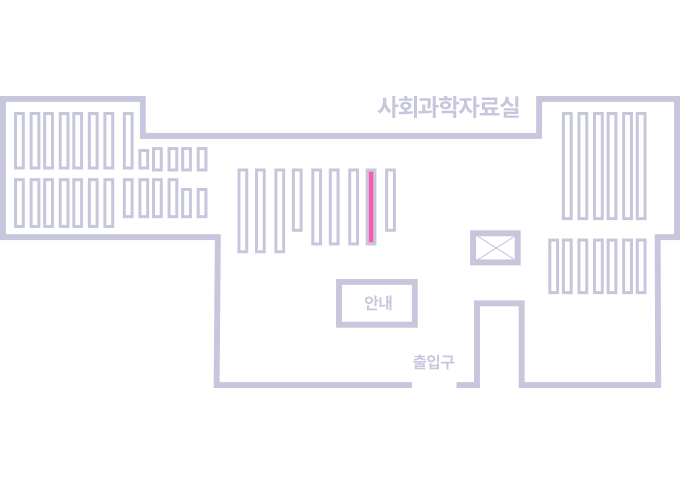

도서위치안내: / 서가번호:

우편복사 목록담기를 완료하였습니다.

*표시는 필수 입력사항입니다.

저장 되었습니다.