권호기사보기

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 대표형(전거형, Authority) | 생물정보 | 이형(異形, Variant) | 소속 | 직위 | 직업 | 활동분야 | 주기 | 서지 | |

|---|---|---|---|---|---|---|---|---|---|

| 연구/단체명을 입력해주세요. | |||||||||

|

|

|

|

|

|

* 주제를 선택하시면 검색 상세로 이동합니다.

표제지

목차

국문요약 8

제1장 서론 9

제2장 관련 연구 15

2.1. Transformer 15

2.2. BERT 22

2.3. GAN 29

2.4. 데이터 증강 기법 34

2.5. 감성분석 35

제3장 학습 데이터 구축 38

제4장 실험 및 결과 41

4.1. 실험환경 41

4.2. 실험 기법 41

4.3. 실험결과 43

제5장 결론 46

5.1. 결론 및 시사점 46

5.2. 향후 계획 47

참고 문헌 48

Abstract 52

그림 1. 인공 신경망의 구조 9

그림 2. 트랜스 포머의 인코더-디코더 아키텍처 15

그림 3. 인코더 층을 확대한 그림 17

그림 4. BERT모델의 인코더 층과 어텐션 헤드의 시각화 19

그림 5. 멀티 헤드 어텐션 19

그림 6. 첫번째 문장의 어텐션 시각화 20

그림 7. 두번째 문장의 어텐션 시각화 20

그림 8. 사전 층 정규화와 사후 층 정규화 21

그림 9. 트랜스포머 디코더의 층을 확대한 그림 21

그림 10. BERT의 입력 임베딩과 출력 임베딩 23

그림 11. 문맥정보 임베딩 벡터의 계산 23

그림 12. BERT Layer 1개를 도식화 한 그림 24

그림 13. BertTokenizer의 결과 25

그림 14. BERT의 Position Embedding 25

그림 15. BERT의 Segment Embedding 26

그림 16. BERT의 마스크드 언어 27

그림 17. GAN 네트워크 29

그림 18. DCGAN의 생성자 네트워크 구조 30

그림 19. CycleGAN의 학습데이터와 pix2pix의 학습데이터의 차이 32

그림 20. VQ-GAN 아키텍체 33

그림 21. 사전기반 감정분석 36

그림 22. 기계학습 기반 감성분석 37

그림 23. 데이터셋의 라벨 분포 39

그림 24. 길이가 1인 데이터들 39

그림 25. 데이터셋의 품사 빈도수 그래프 40

그림 26. 각 EDA 기법의 정확도 비교 44

그림 27. 각 기법에 따른 BERT BASE 모델과 BERT LARGE 모델의 성능 비교 45

수식 1. 어텐션 함수 13

수식 2. 새로운 임베딩 17

수식 3. Least Square Loss 31

*표시는 필수 입력사항입니다.

| *전화번호 | ※ '-' 없이 휴대폰번호를 입력하세요 |

|---|

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 번호 | 발행일자 | 권호명 | 제본정보 | 자료실 | 원문 | 신청 페이지 |

|---|

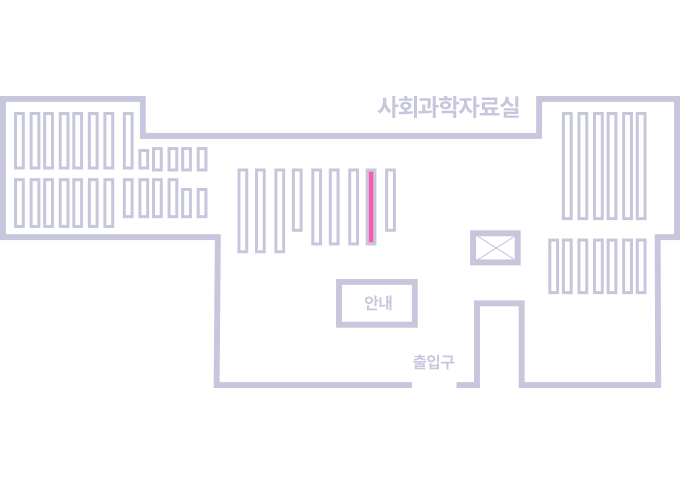

도서위치안내: / 서가번호:

우편복사 목록담기를 완료하였습니다.

*표시는 필수 입력사항입니다.

저장 되었습니다.