권호기사보기

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 대표형(전거형, Authority) | 생물정보 | 이형(異形, Variant) | 소속 | 직위 | 직업 | 활동분야 | 주기 | 서지 | |

|---|---|---|---|---|---|---|---|---|---|

| 연구/단체명을 입력해주세요. | |||||||||

|

|

|

|

|

|

* 주제를 선택하시면 검색 상세로 이동합니다.

표제지

요약

목차

Ⅰ. 서론 6

1. 연구의 배경 및 목적 6

Ⅱ. 이미지를 활용한 주행 환경 객체 검출 9

1. 연구 개요 9

2. 관련 연구 9

3. 실험 결과 11

Ⅲ. 점군을 활용한 주행 환경 객체 검출 15

1. 연구 개요 15

2. 관련 연구 15

1) 이미지 투영 방식 15

2) 복셀 기반 방식 16

3) 포인트 기반 방식 16

3. 제안 방법 17

4. 실험 결과 18

Ⅳ. 점군과 이미지를 활용한 주행 환경 객체 검출 24

1. 연구 개요 24

2. 관련 연구 24

2.1. 이미지만을 이용한 Object Detection 24

2.2. LiDAR 센서 기반의 점군 데이터를 이용한 Object Detection 24

2.3. 이미지와 점군 데이터를 이용한 Object Detection 25

3. 제안 방법 25

3.1. 전체 구조 25

3.2. 이미지 활용 인코더 네트워크 26

3.3. 점군 활용 인코더 네트워크 27

3.4. 융합 인코더 네트워크 & 디코더 네트워크 27

4. 실험 결과 28

4.1. 환경 세팅 및 데이터셋 구성 28

4.2. 구현 결과 비교 및 시각화 28

Ⅴ. 결론 30

참고문헌 31

Abstract 34

그림 1.1. 주행 환경 객체 검출에 사용하는 데이터 종류 6

그림 1.2. SOTA 모델들의 다양한 객체 검출 방식 7

그림 2.1. 객체 분할 기법 9

그림 2.2. Mask2former 네트워크 구조 10

그림 2.3. 학습 완료된 네트워크의 NuImages validation 데이터 추론 결과 14

그림 3.1. Centerformer 네트워크 전체적인 구조 17

그림 3.2. 제안 네트워크 구조 18

그림 3.3. Centerformer와 변경된 구조 모델의 시각화 23

그림 4.1. 제안 네트워크 구조 25

그림 4.2. Depth LSS Transform에서의 Lift 단계 26

그림 4.3. Swin Transformer 구조 27

그림 4.4. 기존 모델 loss 계산값 28

그림 4.5. 구조가 변경된 모델 loss 계산값 29

본 연구에서는 딥러닝 기법을 활용한 이미지와 점군을 통해 주행 환경 객체 검출에 대한 다양한 방식을 제안한다. 현재 자율주행차나 로봇의 인지 분야에서 편의성을 위해 사람과 같은 인지능력이 요구되고 있다. 점군으로 표현된 데이터의 경우 물체 간의 거리나 해당 물체 위치를 정확하게 파악할 수 있다는 장점을 통해 많은 연구가 진행 중에 있다 이미지로 표현된 데이터의 경우 점군에서의 객체 크기보다 더 커서 3D 정보보단 좋은 성능을 보여주고 있어 활발한 연구가 진행되고 있다. 최신 연구로는 3D 객체 정보가 2D 객체 정보보다 사이즈가 작다는 단점과 2D 정보는 정확한 물체간의 거리를 측정할 수 없다는 단점을 상호보완해서 이미지 데이터와 점군 데이터 간의 sensor fusion을 하는 연구도 활발히 진행되고 있다. 본 논문에서는 이미지와 점군 데이터 처리 방식을 통해 성능 및 효율성을 비교해보고 높여줄 가능성을 가진 연구를 제시한다.

첫 번째로, 이미지 데이터를 여러 이미지를 다루는 기법을 쉽게 사용할 수 있는 딥러닝 네트워크 구조를 사용하여 일반적인 성능을 검증했으며, 두 번째는 점군 데이터의 bev feature값들을 transformer 구조의 decoder cross attention 부분에 따로따로 넣어 특징치를 최대로 뽑는 방식을 적용해 기존 모델과의 비교 분석하였으며, 마지막으로 이미지 데이터와 점군 데이터를 같이 사용해 정확한 깊이 정보를 추정할 수 없는 이미지 데이터의 단점을 깊이 정보를 추정할 수 있는 점군 데이터로 보완하고 3D 공간에서의 매우 작은 객체 사이즈라는 점군 데이터의 단점을 2D 공간이여서 객체가 상대적으로 큰 이미지 데이터로 보완하는 방식을 통해 점군 데이터를 이용하는 모델에 이미지 데이터를 fusion해 비교해보았다.*표시는 필수 입력사항입니다.

| *전화번호 | ※ '-' 없이 휴대폰번호를 입력하세요 |

|---|

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 번호 | 발행일자 | 권호명 | 제본정보 | 자료실 | 원문 | 신청 페이지 |

|---|

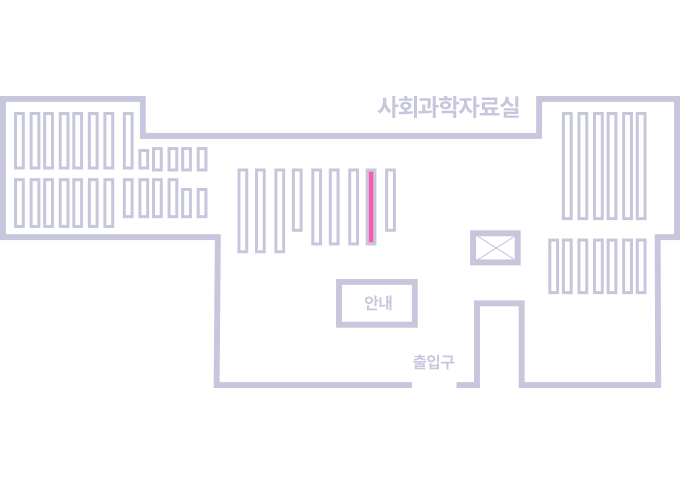

도서위치안내: / 서가번호:

우편복사 목록담기를 완료하였습니다.

*표시는 필수 입력사항입니다.

저장 되었습니다.