권호기사보기

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 대표형(전거형, Authority) | 생물정보 | 이형(異形, Variant) | 소속 | 직위 | 직업 | 활동분야 | 주기 | 서지 | |

|---|---|---|---|---|---|---|---|---|---|

| 연구/단체명을 입력해주세요. | |||||||||

|

|

|

|

|

|

* 주제를 선택하시면 검색 상세로 이동합니다.

표제지

목차

국문초록 11

ABSTRACT 16

Ⅰ. 서론 21

A. 이론적 배경 23

1. 다계통 위축증 (Multiple System Atrophy) 23

2. 자기공명영상 (Magnetic Resonance Imaging, MRI) 27

3. 자화율 강조 영상 (Susceptibility Weighted Imaging) 31

4. 딥러닝 (Deep Learning) 33

Ⅱ. 연구 목표 41

Ⅲ. 연구 방법 42

A. 실험 대상 42

1. 데이터 획득 43

B. 데이터 전처리 45

1. 영상 처리 45

2. 데이터 증대 46

3. 데이터 라벨링 51

C. 인공지능 52

1. Lenet5 52

2. VGG 55

3. ResNet 58

4. Inception 61

5. EfficientNet 64

6. MobileNet 67

7. 학습 파라미터 70

D. 학습 74

1. 모델 구조 최적화 74

2. 배치사이즈별 학습 75

3. Multifold Cross Validation 77

Ⅳ. 연구 결과 78

Ⅴ. 고찰 91

Ⅵ. 결론 93

Ⅶ. 참고문헌 94

Figure 1. Brain sagittal MRI in patients with OPA 24

Figure 2. T1 relaxation process 29

Figure 3. Diagram of T2 (spin-spin, transverse) relaxation 30

Figure 4. Images in a 74-year-old man who presented with aphasia and was found to have a high-grade left temporal glioma at 1.5-T MRI (top).... 32

Figure 5. DNN architecture 34

Figure 6. A graph in which the value of the loss function converges to a minimum as the weight changes. Initial Weight is the initial weight. 37

Figure 7. Example of edge detected through sobel filter 38

Figure 8. Example of convolution operation 39

Figure 9. (Left) Max pooling example for 2x2 pooling, (Right) Average pooling example 40

Figure 10. RoI extracted from axial SWI 43

Figure 11. The region of interest according to grade 44

Figure 12. (Left) Original image, (Right) Normalized image 45

Figure 13. (Left) Original image, (Right) Horizontally flipped image 46

Figure 14. The result of rotating about the center of the image through an affine matrix 49

Figure 15. (Left) Original image, (Right) Histogram equalized image 50

Figure 16. Lenet5 architecture used in this study 54

Figure 17. VGG architecture used in this study 57

Figure 18. ResNet architecture used in this study 60

Figure 19. Inception model architecture used in this study 62

Figure 20. EfficientNet architecture used in this study 66

Figure 21. MobileNet architecture used in this study 69

Figure 22. Visual representation of Precision and Recall metrics in the context of relevant and retrieved elements. The diagram illustrates the... 73

Figure 23. LeNet5 training results using optimal batch size and 5-fold cross validation. Subplots: (1,1) training accuracy, (1,2) validation accuracy, (2,1) training loss, and (2,2) validation loss. Each reflects trends across all folds. 85

Figure 24. VGG training results using optimal batch size and 5-fold cross validation. Subplots: (1,1) training accuracy, (1,2) validation accuracy, (2,1) training loss, and (2,2) validation loss. Each reflects trends across all folds. 86

Figure 25. ResNet training results using optimal batch size and 5-fold cross validation. Subplots: (1,1) training accuracy, (1,2) validation accuracy, (2,1) training loss, and (2,2) validation loss. Each reflects trends across all folds. 87

Figure 26. Inception model training results using optimal batch size and 5-fold cross validation. Subplots: (1,1) training accuracy, (1,2) validation accuracy, (2,1) training loss, and (2,2) validation loss. Each reflects trends... 88

Figure 27. EfficientNet training results using optimal batch size and 5-fold cross validation. Subplots: (1,1) training accuracy, (1,2) validation accuracy, (2,1) training loss, and (2,2) validation loss. Each reflects trends... 89

Figure 28. MobileNet training results using optimal batch size and 5-fold cross validation. Subplots: (1,1) training accuracy, (1,2) validation accuracy, (2,1) training loss, and (2,2) validation loss. Each reflects trends across all folds. 90

Figure 29. Time Percentage Statistics Spent on AI Projects 92

본 연구는 딥러닝 (Deep Learning) 기술을 통해 자화율 강조영상(Susceoptibility Weighted Image, SWI)에서 다계통 위축증 (Multiple System Atrophy, MSA)의 중증도분류의 유효성을 알아보고, 적합한 인공지능 모델을 탐색하는 것을 목표로 한다.

다계통 위축증 (Multiple System Atrophy, MSA)은 만성 퇴행성 신경계 질환으로, 파킨슨 증상과 함께 다른 신경계통의 이상 증상(올리보폰토소 뇌 위축, 샤이-드래거 증후군, 줄무늬체흑질 변성 등)이 동반될 수 있는 복합적인 질환이다. 현재 MSA는 완치할 수 있는 치료법이 없으며, 증상 완화를 목적으로 약물 치료가 이루어지고 있다. 이러한 상황에서 질병의 초기 단계에서 빠르고 정확한 진단이 중요하게 여겨지고 있다.

MSA 환자의 뇌를 자화율강조영상(Susceptibility Weighted Image, SWI)을 통해 관찰하면, 피각의 화소 강도가 정상인과 비교하여 상대적으로 약하게 나타난다. 이러한 특성을 바탕으로 양산 부산대학병원의 L,J.H. 등은 화소 강도 및 비정상적인 국소화 등을 종합하여 Grade 0에서 Grade 3까지 4단계 등급으로 분류하고 있다.

본 연구에서는 MSA 환자의 SWI 영상을 기반으로 putamen 영역의 정밀한 분류를 목표로 한다. 초기 연구 방향의 한계를 극복하기 위해, 데이터의 다양성 확보와 품질 향상을 위해 여러 전처리 방법을 적용하였다. 합성곱 신경망(Convolution Neural Network, CNN)과 잔차 신경망(Residual neural network)을 중심으로, 특히 LeNet과 EfficientNet 아키텍처를 사용하여 성능을 비교 분석하였다. 다양한 학습 조건 하에서의 성능을 평가하였고, 최적의 아키텍처와 배치 사이즈를 결정하였다.

본 연구에서 사용된 MSA 환자의 뇌 MR 영상은 양산 부산대학병원 신경과에서 내원한 MSA 환자 41명을 대상으로 3.0T MRI로 획득하였다. SWI 영상의 파라미터는 다음과 같다: TR = 28 ms, TE = 20 ms, Flip angle = 15°, matrix size = 320 x 240 (height x width), slice thickness = 2 mm. MSA 환자 중 17명에 대한 추적 관찰을 통해 추가적인 영상을 획득하여, 총 58개의 SWI 영상을 확보하였다. 피각의 화소 강도 기반 중증도 분류는 신경과 전문의(L,J.H.)와 신경방사선의(B.S.K)의 두 명의 평가자에 의해 진행되었다. 영상에서 피각의 신호 강도와 분포를 평가하여 각 SWI 영상에 Grade를 부여하였다. 추출된 관심 영역에서는 피각이 있는 부분을 높이 56픽셀, 너비 56픽셀로 잘라냈다. 잘라낸 이미지들은 0~1 범위의 선형 매핑을 통해 다이나믹 레인지를 확장하는 최소-최대 정규화 (Min-Max Normalization)를 진행하였다. 이후 모든 피각 이미지에 대하여 좌우반전을 통해 데이터를 2배로 증대시켰으며, 추가적으로 히스토그램 정규화를 통해 이미지의 피처를 유지한 채로 데이터를 또 다시 2배로 증대시키고 마지막으로 이미지 회전을 통해 모든 이미지에 대하여 15°, 10°, 5°, -5°, -10°, -15°씩 추가적으로 이미지를 증대했으며 총 데이터는 28배로 증대되었다. 히스토그램 정규화는 이미지의 프로세싱보다는 데이터 증대의 목적으로 진행되었다.

본 연구에서는 MSA 중증도 분류를 위해 다양한 CNN 구조를 활용하였다. 구체적으로, LeNet-5, VGG 네트워크, ResNet, Inception, EfficientNet, 그리고 MobileNet을 기반으로 한 모델들을 사용하였다. 이러한 모델들은 영국 옥스퍼드 대학의 Visual Geometry Group, Microsoft Research, 그리고 다른 연구 그룹들에서 창안된 네트워크를 바탕으로 하였다. 해당 인공지능 알고리즘들을 활용하여 두 전문의가 평가한 MSA 중증도 데이터를 학습시켰다. 본 연구의 목적은 이러한 다양한 인공지능 모델들을 통해 MSA 중증도 분류가 유효하게 이루어질 수 있는지, 그리고 MSA 중증도 분류에 어떤 인공지능 알고리즘이 가장 적합한지를 탐색하는 것이다.

본 연구에서는 피각을 이용하여 MSA 환자를 분류하기 위해 LeNet-5, VGG, ResNet, Inception, EfficientNet, 그리고 MobileNet의 6개 모델을 사용하였다. 각 모델들은 초기 convolution 레이어의 출력 필터 채널의 수를 바꿔가며 실험하였다. 모든 모델에 대해 최적의 아키텍처를 실험적으로 파악한 뒤, 2, 4, 8, 16, 32, 64, 128, 256의 다양한 배치 크기로 학습을 수행하였다. 이러한 방식으로 MSA 환자의 피각 기반 분류 성능을 극대화하기 위한 모델 및 학습 전략을 탐색하였다.

본 연구에서는 다양한 딥러닝 모델들의 성능을 평가하기 위해 모델의 필터 수에 따른 학습 과정에서 train set과 validation set에 대한 loss, 정확도, 그리고 마이크로 평균 F1 스코어 (micro-averaged F1 score)를 기준으로 비교하였다. 이러한 평가 기준을 선택한 이유는, 마이크로 평균 F1 스코어가 클래스 간 불균형을 고려하여 각 클래스에 속하는 샘플 수를 균등하게 가중치를 부여하기 때문이다. 이는 데이터셋에 존재하는 소수 클래스의 중요도를 높이고, 모델이 소수 클래스에 대해서도 높은 성능을 낼 수 있도록 격려한다. 또한, F1 스코어는 정밀도와 재현율을 모두 고려하는 지표로, 모델이 양성 샘플을 정확하게 예측하는 동시에, 실제 양성 샘플을 놓치지 않도록 하는 균형 잡힌 성능 평가를 가능하게 한다. 이는 특히 본 연구의 데이터셋처럼 train, validation, test set의 개수가 각각 3,326(60%), 1,426(25%), 792(15%)로 구성되어 있어 클래스 불균형이 발생하기 쉬운 경우에 매우 중요하다.

각 모델별로 실험적으로 결정된 최적의 배치 사이즈는 다음과 같았다: LeNet-5는 4, VGG는 8, ResNet은 16, Inception은 32, EfficientNet과 MobileNet은 각각 8이었다. 해당 배치 사이즈로 각 모델을 학습시킬 때, LeNet-5와 EfficientNet을 제외한 나머지 모델들에서는 학습이 불안정하게 진행되었고, 결과적으로 과적합의 현상이 나타났다.

Loss 계산을 위해 1에서 F1 score를 뺀 값을 사용하였다. 특히, LeNet-5와 EfficientNet 모델에서 test set에 대한 정확도는 각각 0.9924, 0.9116으로 나타났으며, 마이크로 평균 F1 score 기반의 loss(1-f1 score)는 각각 0.0089, 0.0861로 측정되었다. 또한, multifold cross validation 과정에서의 validation loss mean 값은 0.0088과 0.0861로, validation loss의 표준편차(std)는 각각 0.0036, 0.011로 나타났다.

이 결과를 바탕으로 본 연구에서는 LeNet-5와 EfficientNet 모델이 MSA 환자의 피각 기반 분류에서 뛰어난 성능을 보이며, 해당 애플리케이션에 적합하다는 것을 확인하였다.

모델의 복잡도와 성능 사이의 관계를 고려하였을 때, 모든 딥러닝 아키텍처가 동일한 성능을 나타내지 않았다. 특히, EfficientNet과 Lenet은 안정적인 성능과 일관된 학습 및 검증 결과를 보여주었으며, ResNet은 높은 학습 정확도를 보였지만, 검증 과정에서 불안정한 성능을 나타냈다. 이러한 결과는 각 모델의 아키텍처 특성이 MSA 환자 분류에 다르게 작용함을 시사한다. 이를 통해 본 연구에서 제안된 방법론이 MSA 환자의 정확한 진단에 중요한 기준이 될 것으로 기대된다.

추후 연구를 통해, SWI 영상에서 피각이 있는 영역을 분할하여 해당 부분을 3D로 인공지능에 학습시키는 방법을 탐구할 예정이다. 이 방법은 2D 슬라이스 단면보다 더 많은 정보를 활용할 수 있게 하여, MSA 진단의 정확도를 더욱 향상시킬 것으로 기대된다.

본 연구는 2D 슬라이스 단면에서 피각이 있는 영역(56x56)만을 crop하여 MSA 중증도 분류 모델을 개발하였다. 그러나 이 방법은 이미지에서 얻을 수 있는 정보의 한계가 있어, 다양한 특징을 활용한 정확한 분류를 위한 확장성이 요구된다. 추후 연구에서는 SWI 영상 내의 피각 있는 부분을 3D 형태로 분할하여 딥러닝 모델에 학습시킬 계획이다. 이 방법을 통해 이미지로부터 보다 많은 정보를 추출하여 MSA 중증도 분류의 정확도를 향상시킬 것으로 예상된다. 더 나아가, 추가 데이터 및 첨단 기술의 도입으로 더욱 정밀한 분류 모델의 개발이 가능할 것이며, 이것은 MSA 진단에 결정적인 도움을 제공할 수 있을 뿐만 아니라 다른 의료 진단 AI 분야에도 기여할 것으로 기대된다.*표시는 필수 입력사항입니다.

| *전화번호 | ※ '-' 없이 휴대폰번호를 입력하세요 |

|---|

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 번호 | 발행일자 | 권호명 | 제본정보 | 자료실 | 원문 | 신청 페이지 |

|---|

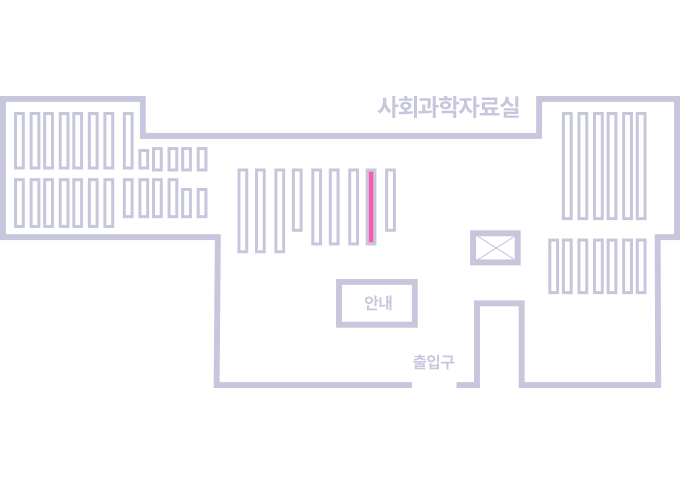

도서위치안내: / 서가번호:

우편복사 목록담기를 완료하였습니다.

*표시는 필수 입력사항입니다.

저장 되었습니다.