권호기사보기

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 대표형(전거형, Authority) | 생물정보 | 이형(異形, Variant) | 소속 | 직위 | 직업 | 활동분야 | 주기 | 서지 | |

|---|---|---|---|---|---|---|---|---|---|

| 연구/단체명을 입력해주세요. | |||||||||

|

|

|

|

|

|

* 주제를 선택하시면 검색 상세로 이동합니다.

목차

개체명 사실 판별을 통한 기계 요약의 사실 불일치 해소 = Solving factual inconsistency in abstractive summarization using named entity fact discrimination / 신정완 ; 노윤석 ; 송현제 ; 박세영 1

요약 1

Abstract 1

1. 서론 2

2. 관련 연구 3

2.1. 사실 불일치 평가 3

2.2. 사실 일치를 위한 요약 생성 및 교정 3

3. 개체명 사실 판별 및 불일치 교정을 통한 기계 요약문의 사실 불일치 해소 3

3.1. 개체명 사실적 판별 3

3.2. 사실 불일치 교정 모델 5

3.3. 모델 구현 및 학습 5

4. 실험 5

4.1. 실험 환경 5

4.2. 실험 결과 6

4.3. 기계 요약문 수정 실험 7

5. 결론 및 향후 연구 9

References 9

[저자소개] 10

기계 요약의 사실 불일치 문제란 요약 모델이 생성한 요약문이 원문과 사실이 일치하지 않는 문제다. 사실 불일치는 개체명에서 주로 발생하므로 기존 연구들은 요약문의 잘못된 개체명을 교정하여 사실적 불일치를 해결하였다. 하지만, 명시적인 개체명 사실 불일치 판별 없이 모든 개체명을 순차적으로 교정하거나 모두 마스킹하여 교정을 시도하였다. 모든 개체명을 교정하는 연구는 원문과 일치하는 개체명도 교정을 시도하는 문제점과 마스킹되어 사실 정보임에도 불구하고 정보를 손실시키는 문제가 발생한다. 본 논문에서는 기존 연구들의 단점을 해결하기 위해 개체명 사실 여부를 판별한 뒤 사실 불일치 개체명에 대해서만 교정을 하는 방법을 제안한다. 이를 통해 사실 불일치 개체명이 발생시키는 오류를 방지할 수 있으며, 반대로 사실 일치 개체명에 대한 정보를 최대한 활용할 수 있다. 실험을 통해 제안한 방법이 기존 연구들보다 요약문의 사실 불일치를 잘 해소함을 보였다.

Factual inconsistency in abstractive summarization is a problem that a generated summary can be factually inconsistent with a source text. Previous studies adopted a span selection that replaced entities in the generated summary with entities in the source text because most inconsistencies are related to incorrect entities. These studies assumed that all entities in the generated summary were inconsistent and tried to replace all entities with other entities. However, this was problematic because some consistent entities could be replaced and masked, so information on consistent entities was lost. This paper proposes a method that sequentially executes a fact discriminator and a fact corrector to solve this problem. The fact discriminator determines the inconsistent entities, and the fact corrector replaces only the inconsistent entities. Since the fact corrector corrects only the inconsistent entities, it utilizes the consistent entities. Experiments show that the proposed method boosts the factual consistency of system-generated summaries and outperforms the baselines in terms of both automatic metrics and human evaluation.| 번호 | 참고문헌 | 국회도서관 소장유무 |

|---|---|---|

| 1 | 1 ] R. Nallapati, B. Zhou, C. dos Santos, C. Gulcehre, and B. Xiang, "Abstractive text summarization using sequence-to-sequence RNNs and beyond,"Proc. of the 20th SIGNLL Conference on Computational Natural Language Learning, pp. 280-290, 2016. | 미소장 |

| 2 | 2 ] A. See, P. J. Liu, and C. D. Manning, "Get to the point: Summarization with pointer-generator networks,"Proc. of the 55th Annual Meeting of the Association for Computational Linguistics, pp. 1073-1083, 2017. | 미소장 |

| 3 | 3 ] M. Lewis, Y. Liu, N. Goyal, M. Ghazvininejad, A. Mohamed, O. Levy, V. Stoyanov, and L. Zettlemoyer, "BART: Denoising sequence-to-sequence pre-training for natural language generation, translation, and comprehension," Proc. of the 58th Annual Meeting of the Association for Computational Linguistics, pp. 7871-7880, 2020. | 미소장 |

| 4 | 4 ] Y. Liu and M. Lapata, "Text summarization with pretrained encoders," Proc. of the 2019 Conference on Empirical Methods in Natural Language Processing and the 9th In ternational Joint Conference on Natural Language Processing, pp. 3730-3740, 2019. | 미소장 |

| 5 | 5 ] J. Zhang, Y. Zhao, M. Saleh, and P. Liu, "PEGASUS:Pretraining with extracted gap-sentences for abstractive summarization," Proc. of the 37th International Conference on Machine Learning, Vol. 119, pp. 11328-11339, 2020. | 미소장 |

| 6 | 6 ] T. Shi, P. Wang, and C. K. Reddy, "LeafNATS: An opensource toolkit and live demo system for neural abstractive text summarization," Proc. of the 2019Conference of the North American Chapter of the Association for Computational Linguistics, pp. 66-71, 2019. | 미소장 |

| 7 | 7 ] A. Fabbri, I. Li, T. She, S. Li, and D. Radev, "Multi-news: A large-scale multi-document summarization dataset and abstractive hierarchical model,"Proc. of the 57th Annual Meeting of the Association for Computational Linguistics, pp. 1074-1084, 2019. | 미소장 |

| 8 | 8 ] Z. Cao, F. Wei, W. Li, and S. Li, "Faithful to the original: Fact aware neural abstractive summarization,"Proc. of the AAAI Conference on Artificial Intelligence, Vol. 32, No. 1, 2018. | 미소장 |

| 9 | 9 ] W. Kryscinski, B. McCann, C. Xiong, and R. Socher, "Evaluating the factual consistency of abstractive text summarization," Proc. of the 2020 Conference on Empirical Methods in Natural Language Processing, pp. 9332-9346, 2020. | 미소장 |

| 10 | C. Zhu, W. Hinthorn, R. Xu, Q. Zeng, M. Zeng, X. Huang, and M. Jiang, "Enhancing factual consistency of abstractive summarization," Proc. of the 2021 Conference of the North American Chapter of the Association for Computational Linguistics:Human Language Technologies, pp. 718-733, 2021. | 미소장 |

| 11 | Y. Dong, S. Wang, Z. Gan, Y. Cheng, J. C. K. Cheung, and J. Liu, "Multi-fact correction in abstractive text summarization," Proc. of the 2020 Conference on Empirical Methods in Natural Language Processing, pp. 9320-9331, 2020. | 미소장 |

| 12 | J. Park, Y. Noh, and S. Park, "Learning contextual meaning representations of named entities for correcting factual inconsistent summary," Proc. of the 32th Annual Conference on Human and Language Technology, pp. 54-59, 2020. (in Korean) | 미소장 |

| 13 | B. Goodrich, V. Rao, P. J. Liu, and M. Saleh, "Assessing the factual accuracy of generated text,"Proc. of the 25th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining, pp. 166-175, 2019. | 미소장 |

| 14 | A. Wang, K. Cho, and M. Lewis, "Asking and answering questions to evaluate the factual consistency of summaries," Proc. of the 58th Annual Meeting of the Association for Computational Linguistics, pp. 5008-5020, 2020. | 미소장 |

| 15 | E. Durmus, H. He, and M. Diab, "FEQA: A question answering evaluation framework for faithfulness assessment in abstractive summarization," Proc. of the 58th Annual Meeting of the Association for Computational Linguistics, pp. 5055-5070, 2020. | 미소장 |

| 16 | J. Jung, H. Ryu, D. Chang, R. Chung, and S. Jung, "Factual consistency checker through a questionanswer test based on the named entity," Proc. of the 33th Annual Conference on Human and Language Technology, pp. 112-117, 2021. (in Korean). | 미소장 |

| 17 | J. Maynez, S. Narayan, B. Bohnet, and R. McDonald, "On faithfulness and factuality in abstractive summarization," Proc. of the 58th Annual Meeting of the Association for Computational Linguistics, pp. 1906-1919, 2020. | 미소장 |

| 18 | M. Cao, Y. Dong, J. Wu, and J. C. K. Cheung, "Factual error correction for abstractive summarization models," Proc. of the 2020 Conference on Empirical Methods in Natural Language Processing, pp. 6251-6258, 2020. | 미소장 |

| 19 | H. Li, J. Zhu, J. Zhang, and C. Zong, "Ensure the correctness of the summary: Incorporate entailment knowledge into abstractive sentence summarization,"Proc. of the 27th International Conference on Computational Linguistics, pp. 1430-1441, 2018. | 미소장 |

| 20 | T. Falke, L. F. R. Ribeiro, P. A. Utama, I. Dagan, and I. Gurevych, "Ranking generated summaries by correctness: An interesting but challenging application for natural language inference," Proc. of the 57th Annual Meeting of the Association for Computational Linguistics, pp. 2214-2220, 2019. | 미소장 |

*표시는 필수 입력사항입니다.

| *전화번호 | ※ '-' 없이 휴대폰번호를 입력하세요 |

|---|

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 번호 | 발행일자 | 권호명 | 제본정보 | 자료실 | 원문 | 신청 페이지 |

|---|

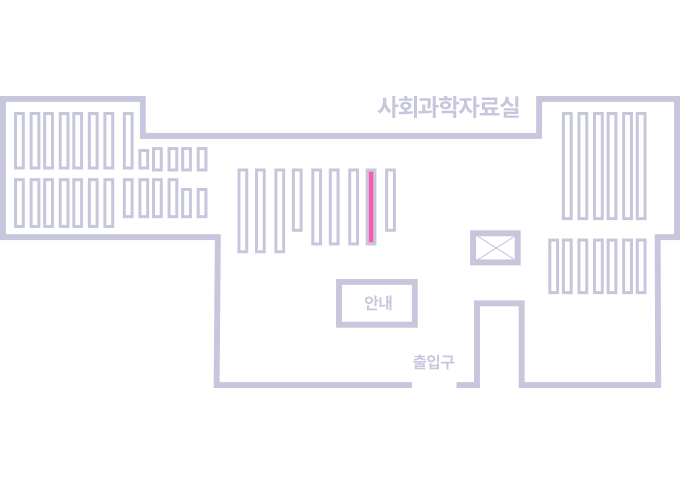

도서위치안내: 정기간행물실(524호) / 서가번호: 국내09

2021년 이전 정기간행물은 온라인 신청(원문 구축 자료는 원문 이용)

우편복사 목록담기를 완료하였습니다.

*표시는 필수 입력사항입니다.

저장 되었습니다.