권호기사보기

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 대표형(전거형, Authority) | 생물정보 | 이형(異形, Variant) | 소속 | 직위 | 직업 | 활동분야 | 주기 | 서지 | |

|---|---|---|---|---|---|---|---|---|---|

| 연구/단체명을 입력해주세요. | |||||||||

|

|

|

|

|

|

* 주제를 선택하시면 검색 상세로 이동합니다.

목차 1

비휘발성 메모리 기반 시스템의 딥러닝 연구를 위한 Full-Stack 시뮬레이터 구현 = Implementing full-stack simulator for deep learning system using non-volatile memory / 최주희 1

요약 1

Abstract 1

1. 서론 2

2. 관련 연구 2

2.1. 비휘발성 메모리 2

2.2. End-to-End Full-Stack 딥러닝 시뮬레이터 3

3. 비휘발성 메모리 기반 딥러닝 시스템 3

4. 실험 및 결과 4

4.1. 실험 환경 4

4.2. 결과 4

5. 결론 5

References 6

[저자소개] 7

| 번호 | 참고문헌 | 국회도서관 소장유무 |

|---|---|---|

| 1 | 1 ] N. P. Jouppi, et al., “In-datacenter performance analysis of a tensor processing unit,” 44th Annual International Symposium on Computer Architecture (ISCA), pp. 1-12, 2017. | 미소장 |

| 2 | 2 ] J. Lee, et al., “UNPU: An energy-efficient deep neural network accelerator with fully variable weight bit precision,” IEEE Journal of Solid-State Circuits, Vol. 54, No. 1, pp. 173-185, 2018. | 미소장 |

| 3 | 3 ] S. Liu, et al., "Cambricon: An Instruction Set Architecture for Neural Networks," 2016 ACM/IEEE 43rd Annual International Symposium on Computer Architecture (ISCA), pp. 393-405, 2016. | 미소장 |

| 4 | 4 ] S. Xi, Y. Yao, K. Bhardwaj, P. Whatmough, G.-Y. Wei, and D. Brooks, “SMAUG: End-to-end full-stack simulation infrastructure for deep learning workloads,” ACM Transactions on Architecture and Code Optimization (TACO), Vol. 17, No. 4, pp. 1-26, 2020. | 미소장 |

| 5 | 5 ] Y. S. Shao, S. L. Xi, V. Srinivasan, G. Wei and D. Brooks, "Co-designing accelerators and SoC interfaces using gem5-Aladdin," 2016 49th Annual IEEE/ACM International Symposium on Microarchitecture (MICRO), pp. 1-12, 2016. | 미소장 |

| 6 | 6 ] S. Tehrani, et al., “Magnetoresistive random access memory using magnetic tunnel junctions,”Proceedings of the IEEE, vol. 91, No. 5, pp. 703-714, 2003. | 미소장 |

| 7 | 7 ] J. Liu, et al. “Voltage-induced magnetization switching method utilizing dipole coupled magnetic tunnel junction,” Journal of Magnetism and Magnetic Materials, Vol. 513, pp. 167105. 2020. | 미소장 |

| 8 | 8 ] K. L. Wang, J. G. Alzate, P. K. Amiri, "Low-power non-volatile spintronic memory: STT-RAM and beyond," Journal of Physics D: Applied Physics, Vol. 46, No. 7, pp. 074003, 2013. | 미소장 |

| 9 | 9 ] P. Saraf, et al. “Endurance enhancement of write-optimized STT-RAM caches,” In Proceedings of the International Symposium on Memory Systems, pp. 101-113, 2019. | 미소장 |

| 10 | N. Rohbani, et al., “Nvdl-cache: Narrow-width value aware variable delay low-power data cache,”In 2019 IEEE 37th International Conference on Computer Design, pp. 264-272, 2019. | 미소장 |

| 11 | A. Monazzah, et al., “CAST: content-aware STT-MRAM cache write management for different levels of approximation,” IEEE Transactions on Computer-Aided Design of Integrated Circuits and Systems, Vol. 39, No. 12, pp. 4385-4398, 2020. | 미소장 |

| 12 | J. Kim and Y. Eom, “Distributed storage system for reducing write amplification on non-volatile memory,” Journal of KIISE, Vol. 47, No. 2, pp. 129-135, 2020. | 미소장 |

| 13 | J. Kim and Y. Eom, “An NVM-based efficient write-reduction scheme for block device driver performance improvement,” Journal of KIISE, Vol. 46, No. 10, pp. 981-988, 2019. | 미소장 |

| 14 | L. Piccolboni, P. Mantovani, G. Di Guglielmo, and L. P. Carloni, "Broadening the exploration of the accelerator design space in embedded scalable platforms," 2017 IEEE High Performance Extreme Computing Conference (HPEC), pp. 1-7, 2017. | 미소장 |

| 15 | T. Liang, L. Feng, S. Sinha, and W. Zhang, "PAAS:A system level simulator for heterogeneous computing architectures," 27th International Conference on Field Programmable Logic and Applications (FPL), pp. 1-8, 2017. | 미소장 |

| 16 | V. Subramanian, “Deep learning with PyTorch: A practical approach to building neural network models using PyTorch,” Packt Publishing Ltd, 2018. | 미소장 |

| 17 | N. Shukla, “Machine Learning with TensorFlow,”Manning Publications, Shelter Island, NY, USA, 2018. | 미소장 |

| 18 | X. Zhang, et al., "DNNBuilder: an Automated Tool for Building High-Performance DNN Hardware Accelerators for FPGAs," 2018 IEEE/ACM International Conference on Computer-Aided Design (ICCAD), pp. 1-8, 2018. | 미소장 |

| 19 | R. Venkatesan, et al., "MAGNet: A Modular Accelerator Generator for Neural Networks," 2019IEEE/ACM International Conference on Computer-Aided Design (ICCAD), pp. 1-8, 2019. | 미소장 |

| 20 | A. Parashar et al., "Timeloop: A Systematic Approach to DNN Accelerator Evaluation," 2019IEEE International Symposium on Performance Analysis of Systems and Software (ISPASS), pp. 304-315, 2019. | 미소장 |

| 21 | A. Jadidi, M. Arjomand, and H. Sarbazi-Azad, “High-endurance and performance-efficient design of hybrid cache architectures through adaptive line replacement,” 17th IEEE/ACM International Symposium on Low-power Electronics and Design, pp. 79-84, 2011. | 미소장 |

| 22 | B. Reagen, et al., "Minerva: Enabling Low-Power, Highly-Accurate Deep Neural Network Accelerators,"2016 ACM/IEEE 43rd Annual International Symposium on Computer Architecture (ISCA), pp. 267-278, 2016. | 미소장 |

| 23 | D.-A. Clevert, et al., “Fast and accurate deep network learning by exponential linear units (elus),”arXiv preprint arXiv:1511.07289, 2015. | 미소장 |

*표시는 필수 입력사항입니다.

| *전화번호 | ※ '-' 없이 휴대폰번호를 입력하세요 |

|---|

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 번호 | 발행일자 | 권호명 | 제본정보 | 자료실 | 원문 | 신청 페이지 |

|---|

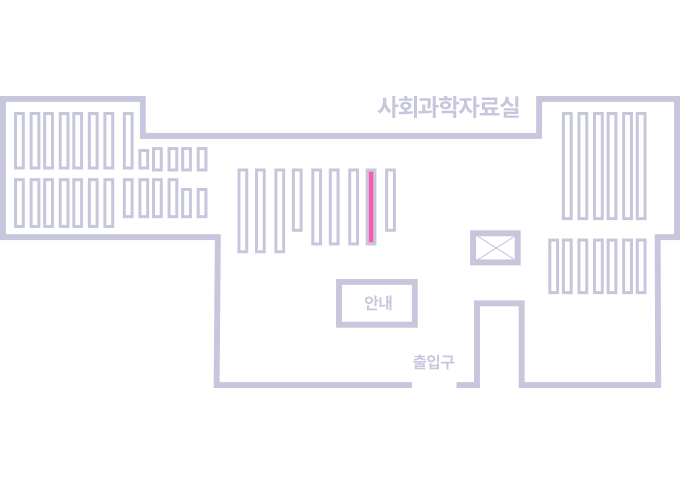

도서위치안내: 정기간행물실(524호) / 서가번호: 국내09

2021년 이전 정기간행물은 온라인 신청(원문 구축 자료는 원문 이용)

우편복사 목록담기를 완료하였습니다.

*표시는 필수 입력사항입니다.

저장 되었습니다.