권호기사보기

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 대표형(전거형, Authority) | 생물정보 | 이형(異形, Variant) | 소속 | 직위 | 직업 | 활동분야 | 주기 | 서지 | |

|---|---|---|---|---|---|---|---|---|---|

| 연구/단체명을 입력해주세요. | |||||||||

|

|

|

|

|

|

* 주제를 선택하시면 검색 상세로 이동합니다.

목차 1

Epoch Score : 정량적 데이터 품질 평가 = Epoch score : dataset verification using quantitative data quality assessment / 김성렬 ; 황태욱 ; 정상근 ; 노윤형 1

요약 1

Abstract 1

1. 서론 2

2. 관련 연구들 2

3. 에폭 스코어(Epoch Score) 2

4. 실험 방법 및 결과 3

4.1. KLUE TC 데이터셋 설명 3

4.2. KLUE TC 에폭 스코어 적용 3

4.3. 재태깅 데이터 성능 검증 4

4.4. CIFAR-10 이미지 데이터셋 설명 4

4.5. CIFAR-10 에폭 스코어 적용 5

4.6. 에폭 스코어 AUC 비교 5

5. 결론 및 향후 연구 6

References 6

[저자소개] 6

| 번호 | 참고문헌 | 국회도서관 소장유무 |

|---|---|---|

| 1 | WANG, Alex, et al. GLUE: A multi-task benchmark and analysis platform for natural language understanding. arXiv preprint arXiv:1804.07461, 2018. | 미소장 |

| 2 | WANG, Alex, et al. Superglue: A stickier benchmark for general-purpose language under standing systems. arXiv preprint arXiv:1905.00537, 2019. | 미소장 |

| 3 | PARK, Sungjoon, et al. KLUE: Korean Language Understanding Evaluation. arXiv preprint arXiv:2105.09680, 2021. | 미소장 |

| 4 | ZHANG, Xiang; ZHAO, Junbo; LECUN, Yann. Character-level convolutional networks for text classification. Advances in neural information processing systems, 2015, 28: 649-657. | 미소장 |

| 5 | DEVLIN, Jacob, et al. Bert: Pre-training of deep bidirectional transformers for language under standing. arXiv preprint arXiv:1810.04805, 2018. | 미소장 |

| 6 | ZHANG, Tianyi, et al. Bertscore: Evaluating text generation with bert. arXiv preprint arXiv:1904.09675, 2019. | 미소장 |

| 7 | WOLF, Thomas, et al. Huggingface's transformers:State-of-the-art natural language processing. arXiv preprint arXiv:1910.03771, 2019. | 미소장 |

| 8 | LEE, Sangah, et al. Kr-bert: A small-scale korean-specific language model. arXiv preprint arXiv:2008.03979, 2020. | 미소장 |

| 9 | K. Kim, “Pretrained language models for korean.”https://github.com/kiyoungkim1/LMkor, 2020. | 미소장 |

| 10 | AKIBA, Takuya, et al. Optuna: A next-generation hyperparameter optimization framework. In:Proceedings of the 25th ACM SIGKDD inter national conference on knowledge discovery &data mining. 2019, pp. 2623-2631. | 미소장 |

| 11 | RADOSAVOVIC, Ilija, et al. Designing network design spaces, In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2020, pp. 10428-10436. | 미소장 |

| 12 | TAN, Mingxing; LE, Quoc. Efficientnet: Rethinking model scaling for convolutional neural networks, In International Conference on Machine Learning, PMLR, 2019. pp. 6105-6114. | 미소장 |

| 13 | ZAGORUYKO, Sergey; KOMODAKIS, Nikos. Wide residual networks. arXiv preprint arXiv:1605.07146, 2016. | 미소장 |

| 14 | XIE, Saining, et al. Aggregated residual trans formations for deep neural networks, In Proceedings of the IEEE conference on computer vision and pattern recognition, 2017. pp. 1492-1500. | 미소장 |

| 15 | Settles, Burr. "Active learning literature survey."(2009). | 미소장 |

| 16 | Mullapudi, Ravi Teja, et al. "Learning Rare Category Classifiers on a Tight Labeling Budget,"Proceedings of the IEEE/CVF International Conference on Computer Vision, 2021. | 미소장 |

*표시는 필수 입력사항입니다.

| *전화번호 | ※ '-' 없이 휴대폰번호를 입력하세요 |

|---|

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 번호 | 발행일자 | 권호명 | 제본정보 | 자료실 | 원문 | 신청 페이지 |

|---|

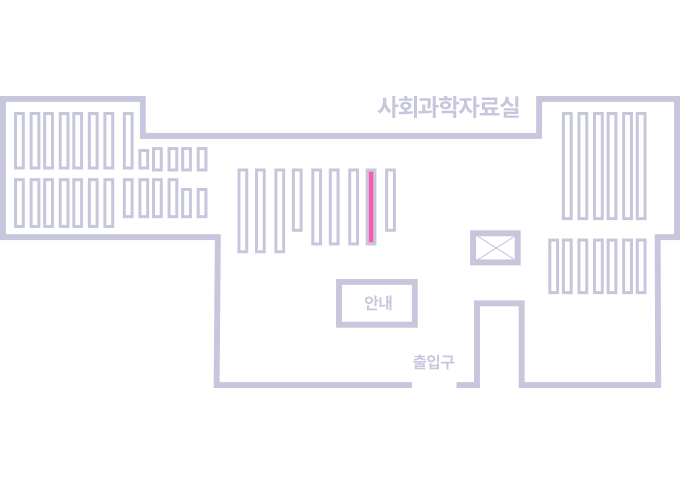

도서위치안내: 정기간행물실(524호) / 서가번호: 국내09

2021년 이전 정기간행물은 온라인 신청(원문 구축 자료는 원문 이용)

우편복사 목록담기를 완료하였습니다.

*표시는 필수 입력사항입니다.

저장 되었습니다.