권호기사보기

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 대표형(전거형, Authority) | 생물정보 | 이형(異形, Variant) | 소속 | 직위 | 직업 | 활동분야 | 주기 | 서지 | |

|---|---|---|---|---|---|---|---|---|---|

| 연구/단체명을 입력해주세요. | |||||||||

|

|

|

|

|

|

* 주제를 선택하시면 검색 상세로 이동합니다.

표제지

국문요약

목차

제 1 장 서론 10

1.1 연구 배경 10

1.2 연구 목적 12

1.3 논문의 구성 13

제 2 장 행동기반제어 14

2.1 계층적인 구조 (Hierarchical Paradigm) 14

2.2 반사적인 구조 (Reactive Paradigm) 16

2.2.1 Subsumption Architecture 17

2.2.2 Motor-Schema 18

2.3 복합적인 구조 20

제 3 장 행동 선택 문제 21

3.1 우선순위에 근거한 명령의 중재 22

3.2 명령의 조합 23

3.2.1 Potential Field Method 23

3.2.2 Fuzzy Logic 24

3.3 DAMN 25

3.4 Voting Algorithm 26

제 4 장 강화학습 28

4.1 Q-learning 28

제 5 장 제안된 구조 31

5.1 Architecture 32

5.2 보상 함수 33

5.3 Command Set Generator 35

5.4 Action-Arbiter 37

5.5 Action Selector 39

제 6 장 모의 실험 40

6.1 실험환경 42

6.1.1. 실험환경 I (복도) 42

6.1.2 실험환경 II (Box Canyon) 43

6.1.3 이동로봇의 상태공간 정의 44

6.2 Behavior Set 46

6.3 실험 결과 47

6.3.1 Episode의 증가에 따른 Q-Value의 변화 47

6.3.2 다중 Target을 갖는 환경에서의 로봇경로 48

6.3.3 Command Set Values 49

6.3.4 Episode의 증가에 따른 시간의 변화 51

제 7 장 결론 및 향후 계획 52

참고문헌 54

ABSTRACT 55

감사의 글 56

그림 2.1 자율이동로봇의 계층적 제어구조의 기능별 모듈 분류 15

그림 2.2 자율이동로봇의 행위기반 제어 구조 17

그림 2.3 Subsumption Architecture 18

그림 3.1 Behavior 사이에 충돌이 일어나는 경우 21

그림 3.2 Brooks의 Subsumption Architecture 22

그림 3.3 Potential Field로 얻은 로봇의 경로 24

그림 3.4 DAMN Architecture 25

그림 5.1 학습을 겸한 Voting을 이용한 Action Selection Architecture 32

그림 5.2 제안된 보상함수 34

그림 5.3 Vector Summation Method 35

그림 5.4 Command Set 36

그림 5.5 Action-Arbiter 37

그림 6.1 α= 0.4, γ= 0.7 인 경우의 결과 41

그림 6.2 모의 실험 환경(복도) 42

그림 6.3 모의 실험 환경 (Box Canyon) 43

그림 6.4 이동로봇의 State 정의 44

그림 6.5 Update Q-Value 47

그림 6.6 Q-Value와 Episode의 관계 48

그림 6.7 로봇의 이동경로 48

그림 6.8 Episode에 의한 State의 수와 시간과의 관계 51

그림 7.1 MARI 53

그림 7.2 Box Canyon 53

표 5.1 Learning Parameters 40

표 6.1 CSG의 결과 (State : 614) 49

표 6.2 CSG의 결과 (State : 694) 49

표 6.3 CSG의 결과 (State : 655) 50

*표시는 필수 입력사항입니다.

| *전화번호 | ※ '-' 없이 휴대폰번호를 입력하세요 |

|---|

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 번호 | 발행일자 | 권호명 | 제본정보 | 자료실 | 원문 | 신청 페이지 |

|---|

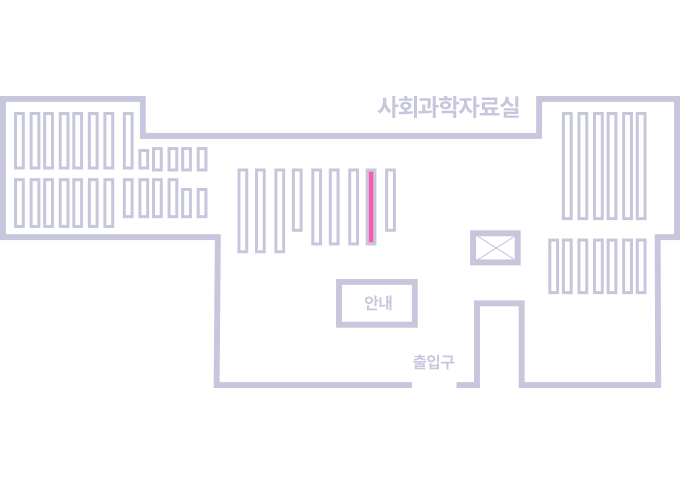

도서위치안내: / 서가번호:

우편복사 목록담기를 완료하였습니다.

*표시는 필수 입력사항입니다.

저장 되었습니다.