권호기사보기

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 대표형(전거형, Authority) | 생물정보 | 이형(異形, Variant) | 소속 | 직위 | 직업 | 활동분야 | 주기 | 서지 | |

|---|---|---|---|---|---|---|---|---|---|

| 연구/단체명을 입력해주세요. | |||||||||

|

|

|

|

|

|

* 주제를 선택하시면 검색 상세로 이동합니다.

Title Page

Abstract

국문요약

Contents

Chapter 1. Overview 24

1.1. Introduction 24

1.2. Problem Statement 25

1.3. Contributions 27

1.4. Outline of the Dissertation 29

Chapter 2. Related Work 31

2.1. Context-aware Content Adaptation 32

2.1.1. Adaptive AR User Interface 32

2.1.2. AR Content Customization 34

2.2. Software Agents in AR Environments 37

2.2.1. Animated AR Agents 37

2.2.2. Reactive Agents to Physical Objects 40

2.3. Toward Intelligent Agents in AR Environments 43

Chapter 3. Context-Aware Mobile Augmented Reality (CAMAR) Systems 45

3.1. Introduction 45

3.2. A Context-Aware Mobile Augmented Reality (CAMAR) System 47

3.2.1. Mobile context awareness 51

3.2.2. Content customization 56

3.2.3. Context-aware content augmentation 58

3.3. Implementation 61

3.4. Experimental Results 65

3.4.1. Evaluation of context awareness 68

3.4.2. Evaluation of content customization 69

3.5. Discussion 71

Chapter 4. AR Agents : Intelligent Agents in CAMAR Systems 73

4.1. Introduction 73

4.2. Literature Review 74

4.3. Intelligent Agents in CAMAR Systems 76

4.3.1. Physical and Synthetic Sensor-based Perception 77

4.3.2. Explanation-based Situation Appraisal 79

4.3.3. Response Generation 81

4.4. Implementation 84

4.5. Experimental Results 89

4.5.1. Observation in Exhibition 91

4.5.2. User Evaluation 93

4.6. Discussion 98

Chapter 5. A Perceptual Attention for Intelligent Agents in CAMAR Systems 100

5.1. Introduction 100

5.2. Literature Review 101

5.2.1. Basic Attention Mechanism for Humans 102

5.2.2. Perceptual Attention for Agents in AR Environments 103

5.2.3. Perceptual Attention for Agents in Virtual Environments 105

5.2.4. Analysis and Comparison 107

5.3. Working Environment 109

5.4. Synthetic Vision for AR Agents 109

5.5. An Object-based Perceptual Attention 114

5.5.1. Attention Allocation 116

5.5.2. Perceptual Memory Management 122

5.6. Realization 125

5.7. Experimental Results 131

5.7.1. Performance Evaluation 131

5.7.2. Comparison with other approaches 138

5.8. Discussion 143

Chapter 6. Conclusions and Future Works 144

6.1. Summary 144

6.2. Future Considerations 146

References 147

Curriculum Vitae 158

Figure 2.1: Adaptive labeling [1]: (a) without label placement (b) with label placement... 33

Figure 2.2: Annotated situation-awareness aid [2]: (a) as a user looks straight ahead... 33

Figure 2.3: Filtering in a mobile AR system [3]: (a) unfiltered view (b) task-oriented... 35

Figure 2.4: Adaptive information filtering [4]: (a) information about a recognized... 36

Figure 2.5: (a) the Welbo interior design assistant [5], (b) the STAR factory training... 39

Figure 2.6: (a) a toy block assembler [9], (b) animated characters in an AR game [10],... 41

Figure 3.1: The CAMAR system augmenting personalized content based on context... 48

Figure 3.2: Comparison of support with and without the CAMAR system. 49

Figure 3.3: Key components for CAMAR systems. 50

Figure 3.4: The description of the context detected by (a) a selection recognition sensor... 51

Figure 3.5: The overall procedure of context awareness in CAMAR systems: The... 53

Figure 3.6: Context integration with 4W1H context. 54

Figure 3.7: An example of a rule for inferring the user's intention using information of... 55

Figure 3.8: Content customization through information filtering, content rating and... 56

Figure 3.9: Content augmentation adaptable to user context. 59

Figure 3.10: The pseudo code for content augmentation. 60

Figure 3.11: Sensors used by our prototype in the test-bed. 62

Figure 3.12: An example of context awareness using sensory information from a camera. 63

Figure 3.13: Physical object recognition: (a) descriptor extraction of features in a... 65

Figure 3.14: Content customization over a map (a) for user A (who prefers to get... 66

Figure 3.15: Content customization (a) for a user who prefers to be supported by... 66

Figure 3.16: Average accuracy of the predicted context in the 8 situations. 69

Figure 3.17: Average quality of the offered content with and without context awareness. 70

Figure 4.1: Key components for AR agents. 77

Figure 4.2: Synthetic sensors for an AR agent: (a) synthetic vision (b) synthetic touch. 78

Figure 4.3: Perception by exploiting information from physical and synthetic sensors. 78

Figure 4.4: An agent's appraisal to perceived information depending on its explanatory... 80

Figure 4.5: Response generation through emotion mapping and movement determina-... 82

Figure 4.6: The visual expressions through the animation sequences. 86

Figure 4.7: The implemented ARGarden: (a) the collaboration between a user with a... 87

Figure 4.8: The bluebird's responses: (a) a "joy" state to a user's appropriate selection,... 90

Figure 4.9: Examples of our implemented agent (a) in a miniature version of a campus 91

Figure 4.10: Demonstration (a) installation (b) users' participation on demonstration. 92

Figure 4.11: Participants' experiences with our demonstration. 93

Figure 4.12: Experimental conditions. 94

Figure 4.13: Average time to perform given task per condition. 95

Figure 4.14: (a) average scores and (b) score distribution on satisfaction of experimental... 96

Figure 4.15: Impressions on an animated bluebird [B] and our bluebird[C]. 98

Figure 5.1: The overall procedure for synthetic vision-based perceptual attention. 101

Figure 5.2: The review of related work. 108

Figure 5.3: Miniature version of a campus as an example of the working environment... 110

Figure 5.4: Extraction of relations between physical objects (a) camera pose estimate... 112

Figure 5.5: The extraction of agent's view. 113

Figure 5.6: The overall procedure of perceptual attention to visible objects. 115

Figure 5.7: The attention policies for perceptual attention. 117

Figure 5.8: A sample object ontology, as used to a prior knowledge for objects. 117

Figure 5.9: The procedure for attention allocation. 120

Figure 5.10: Management of perceptual memory. 124

Figure 5.11: The configuration with a server and a mobile device in our test-bed. 126

Figure 5.12: Physical building recognition and tracking (a) an image from a camera,... 128

Figure 5.13: Example of perceptual attention (a) an object in a camera viewing area 129

Figure 5.14: Perceptual attention after adding a new object (a) camera's view (b)... 130

Figure 5.15: Perceptual attention process to find the gazebo in the view (a) from 2... 133

Figure 5.16: Average time for perceptual processing with a target "gazebo" according... 134

Figure 5.17: Examples of perceptual attention process to find the bench in the view... 135

Figure 5.18: Perceptual attention process to find the building in the view (a) from 2... 136

Figure 5.19: Perceptual attention process to find the trashcan in the view (a) from 2... 137

Figure 5.20: Average time for perceptual processing according to different target ob-... 138

Figure 5.21: Average time for response generation from perception for each decision... 140

Figure 5.22: Average time for response generation from perception according to the... 141

Figure 5.23: Average of relative perceptual processing according to the ratio of mem-... 142

모바일 기기의 급속한 발전과 보급에 따라, 사용자로 하여금 언제 어디서나 필요한 정보를 손쉽게 접근할 수 있도록 하는 다양한 모바일 서비스가 제공되고 있다. 이와 더불어 사용자가 존재하는 공간 상에 컴퓨터가 생성해 내는 콘텐츠를 이음매 없도록 증강 시키는 모바일 증강 현실 기술은 사용자로 하여금 다양한 콘텐츠를 일상 생활의 일부와 같이 경험할 수 있도록 한다. 하지만, 사용자가 접근할 수 있는 모바일 콘텐츠가 급증함에 따라 실제 공간 상에 자연스럽게 증강 하는 것과 더불어 사용자가 원하는 혹은 사용자의 상황에 유용한 콘텐츠를 선별하고 이를 적절한 형태로 제공하는 부분에 대한 고려가 필요한 실정이다..

더 나아가 사용자로 하여금 실제 공간 상에 증강된 콘텐츠와 다양한 상호작용을 가능하도록 하기 위하여, 상호작용형 증강 에이전트에 대한 연구가 진행되고 있다. 이러한 증강 에이전트는 사용자가 존재하는 실제 공간 상에 증강되어 사용자의 상호작용에 따라 실시간으로 적절한 형태의 반응을 가시화함으로써, 사용자로 하여금 해당 에이전트에 대한 공존감을 증대시킨다. 이와 더불어 증강 에이전트는 실제 및 가상 객체들 사이에 가시화되기 때문에, 이러한 환경적 특성을 고려하여 증강 에이전트로 하여금 주변에 존재하는 다양한 형태의 실제 및 가상 객체의 변화를 효율적으로 인지하고 이에 따라 실시간으로 반응을 생성할 수 있어야 하나 기존 연구들은 이에 대한 고려가 미흡한 실정이다.

본 논문에서는, 모바일 사용자의 맥락을 인지하고 이에 따라 개인화된 콘텐츠를 증강 시키는 맥락 인식 모바일 증강 현실 시스템을 개발한다. 이는 환경 혹은 모바일 센서로부터 획득된 정보를 통합 및 해석함으로써 모바일 사용자의 맥락 정보를 실시간으로 추론한다. 그리고 해당 맥락에 가용한 콘텐츠 중 맥락 정보에 적합한 정보 및 형태를 포함하는 콘텐츠를 선별하고 이를 실제 객체에 이음매 없이 증강 시킨다. 이에 대한 유용성을 검토하기 위하여 스마트 환경을 위한 테스트 베드에서 사용자의 맥락을 실시간으로 인지하고 그에 따라 개인화된 콘텐츠를 증강 시키는 프로토타입을 구현하였다. 이에 대한 실험을 통하여, 모바일 증강 현실 시스템에서 사용자의 맥락 인식 및 맥락에 따른 개인화된 콘텐츠 증강을 통하여 제공하는 콘텐츠에 대한 사용자의 만족도를 향상시킬 수 있음을 확인할 수 있었다.

맥락 인식 모바일 증강 현실 시스템에서 사용자의 맥락에 따라 실시간으로 상호작용이 가능한 지능형 에이전트를 제안한다. 특히, 본 연구는 지능형 에이전트로 하여금 다양한 실제 센서 혹은 자체적인 센싱 능력을 통하여 자신의 주변 환경의 변화를 실시간으로 인지할 수 있도록 한다. 그리고 인지된 정보를 자율적으로 평가하고 이에 따라 사회적 반응을 생성함으로써, 그에 따른 시/청각적인 반응을 표현한다. 제안한 지능형 에이전트에 대한 응용 가능성을 검토하기 위하여 실제 및 가상 객체의 변화에 따라 의인화된 반응을 가시화하는 캐릭터를 구현하고 이를 사용자와 협업을 가능하도록 하는 증강 현실 기술 기반 상호작용형 교육 시스템에 구축하였다. 이에 대한 사용성 평가를 통하여 증강 현실 기술 기반 에듀테인먼트 시스템에서 사용자로 하여금 체험에 대한 참여 동기를 유발시키기 위한 필수 요소로서 제안한 지능형 에이전트가 유용함을 검증할 수 있었다.

마지막으로, 본 논문에서는 다양한 가상 및 실제 객체가 혼재하는 증강 현실 공간에서 지능형 에이전트로 하여금 주변에 존재하는 가상 및 실제 객체를 효율적으로 인지할 수 있도록 하는 지각 주의 모델을 제안한다. 이는 카메라의 시야에 존재하는 실제 및 가상 객체 정보를 이용하여 지능형 에이전트로 하여금 주변에 어떠한 실제 및 가상 객체가 존재하는 지를 인지할 수 있도록 한다. 그리고 제안한 모델은 에이전트로 하여금 주변에 존재하는 객체들 중 에이전트의 목표를 달성하는 데 유용한 객체들에게만 주위를 기울일 수 있도록 한다. 더 나아가 이는 에이전트로 하여금 주위를 기울였던 객체에 대한 정보를 유지 및 관리하도록 함으로써, 주변 객체를 인지하는 데 소모되는 불필요한 프로세싱을 감소시킨다. 제안한 모델의 유용성을 확인하기 위하여 캠퍼스 미니어처 내의 빌딩 객체들 사이에 가시화 되며 목표에 관련이 있는 빌딩 객체들에게 관심을 기울이며 반응을 생성하는 증강 캐릭터를 구현하였다. 그리고 실험을 통하여 제안한 지각 주의 모델은 증강 캐릭터로 하여금 주변에 존재하는 가상 및 실제 객체의 변화를 인지하는데 소요되는 지각 부하를 효과적으로 감소시킴으로써, 해당 캐릭터로 하여금 효율적으로 주변을 인지하고 반응할 수 있도록 하는데 기여함을 확인할 수 있었다.

그러므로 본 논문은 사용자가 존재하는 실제 공간 상에 존재하며 해당 공간의 변화를 효율적으로 인지하고 이에 실시간으로 반응하는 지능형 에이전트를 위한 핵심기술을 제시한다. 이들은 실제 및 가상 객체가 공존하는 증강 현실 공간에서 지능형 에이전트로 하여금 사용자와 실시간으로 상호작용을 가능하게 함으로써, 실제 공간상에서 사용자에게 새로운 형태의 상호작용 기법을 제공한다. 더 나아가 이를 기반으로한 다양한 응용 시스템을 구축함으로써, 증강 현실 기술 기반 상호작용형 교육 및 오락 시스템에서의 지능형 에이전트의 응용 가능성을 제시한다. 더 나아가 일상생활에서 사용자로 하여금 자연스럽게 증강 현실 콘텐츠를 경험할 수 있도록 하는 새로운 형태의 상호작용 기법에 대한 기조 연구가 될 것으로 기대된다.*표시는 필수 입력사항입니다.

| 전화번호 |

|---|

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 번호 | 발행일자 | 권호명 | 제본정보 | 자료실 | 원문 | 신청 페이지 |

|---|

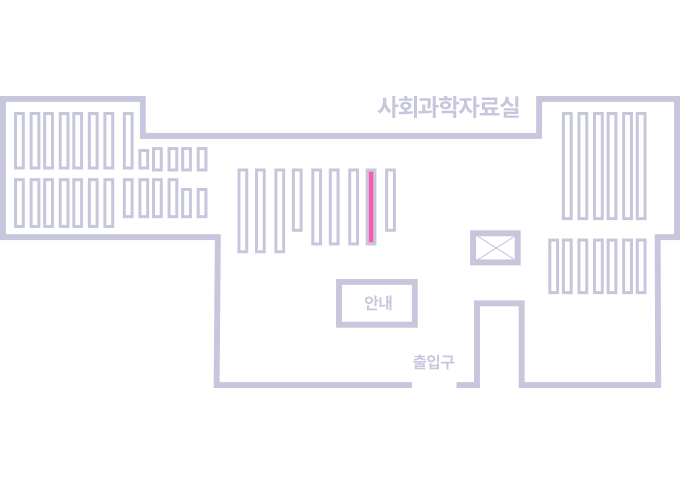

도서위치안내: / 서가번호:

우편복사 목록담기를 완료하였습니다.

*표시는 필수 입력사항입니다.

저장 되었습니다.