권호기사보기

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 대표형(전거형, Authority) | 생물정보 | 이형(異形, Variant) | 소속 | 직위 | 직업 | 활동분야 | 주기 | 서지 | |

|---|---|---|---|---|---|---|---|---|---|

| 연구/단체명을 입력해주세요. | |||||||||

|

|

|

|

|

|

* 주제를 선택하시면 검색 상세로 이동합니다.

Title Page

Contents

초록 10

Ⅰ. Introduction 12

Ⅱ. Image Outpainting 14

1. Introduction 14

2. Related Work 18

1) Image Completion 18

2) Image Captioning 18

3) Text-guided Image Manipulation 19

3. Proposed Method 20

1) Captioning-based Extensive Painting Module 20

2) Image Outpainting 24

3) Wide-range Image Blending 24

4. Experiments 24

1) Base line Methods 25

2) Datasets 25

3) System Set-up 26

4) Quantitative Results 27

5) Qualitative Results 35

6) Ablation Studies 35

5. Limitation 40

Ⅲ. Video Editing 41

1. Introduction 41

2. Related Work 44

1) Text-Guided Editing 44

2) Optical Flow Estimation 45

3. Proposed Method 46

1) Preliminary 49

2) Motion Map Injection Module 49

4. Experiment 52

1) Experimental Setup 52

2) User Study 52

3) Quantitative Results 53

4) Qualitative Results 56

5) Ablation Study 57

6) Application 59

7) Limitation 60

Ⅳ. Conclusion 61

Ⅴ. Reference 63

Figure 1. Illustration of image outpainting and wide-range image blending. Image outpainting is a task which aims to extend a given image beyond its... 14

Figure 2. Overall process of extensive painting with the proposed CEP module. Left: Image outpainting is performed through our CEP module... 19

Figure 3. Qualitative results of image outpainting task on AmsterTime dataset. 31

Figure 4. Qualitative results of wide-range image blending task on Image 4K dataset. 34

Figure 5. Effect of optimizing an image captioning model on wide-range image blending; Withoutthe SCST optimization process, the text-guided image... 35

Figure 6. Effect of captions for extensive painting; Image captions for missing region provides diverse and natural images. Red boxes indicate... 36

Figure 7. Comparison of OFA and ClipCap captionings with GLIDE 39

Figure 8. Failure cases; The word "blurry" in captions generated blurry images. Red boxes indicate generated regions. 40

Figure 9. Comparison of video editing output and attention map compared to existing methods. Both Image-P2P and Video-P2P failed to accurately est... 41

Figure 10. Overall framework of this study. First, the T2V-Model generates an attention map by receiving video and prompts as input.... 47

Figure 11. Examples that the existing video editing model could not edit object having motion. However, editing was performed by directly injecting... 48

Figure 12. Experimental results of our study. It shows the result of four examples corresponding to each target prompt. The top row of each... 55

Figure 13. Output of various methods to measure the correlation between the motion map and the attention map. 57

Figure 14. Editing method for objects moving in the direction specified by the user. Before editing, the user first selects one of the 8 directions. 58

Figure 15. Video-p2p and our video editing results and estimated optical flow in inaccurate motion estimation 60

생성형 AI의 최근 급속한 발전은 visual modality와 text modality를 융합하여 새로운 기술의 장을 열었다. 그 중, text-guided diffusion model은 주어진 text prompt에 따라 다양한 이미지를 손쉽게 생성하거나 조작할 수 있다. 또한 이미지뿐만 아니라 비디오를 생성하거나 편집할 수 있다. 이러한 생성형 AI가 활용되는 분야 중, 이미지의 손상된 부분이나 알려지지 않은 부분에 대해 이미지를 복원 혹은 생성하는 image completion 분야는 학습하지 않은 데이터를 생성해야 하기 때문에 다른 task들 보다 상대적으로 어려운 분야이다. 이미지와의 거리가 먼 외부에 대한 영역을 생성하기 위해 많은 연구들이 있었으나 결과는 만족스럽지 못하다. 본 연구의 첫 번째 연구인 image outpainting은 이미지를 text prompt로 생성하는 text-guided diffusion model과 이미지에 대한 caption을 생성하는 image captioning model을 활용하여 좋은 성능으로 image outpainting task를 수행하는 통합적인 프레임워크를 제안한다. 이는 많은 text-guided diffusion model과 image captioning model을 활용할 수 있는 효율적이고 범용적인 framework이다. 제안하는 방법을 통해 image outpainting 뿐만 아니라 멀리 떨어져 있는 두 이미지 사이의 공간에 대한 영역을 생성할 수 있는 wide-range image blending task 또한 수행할 수 있다.

또한 최근에는 생성형 AI를 통해 ext prompt와 이미지 사이의 관계를 나타내는 attention map을 활용한 비디오 편집까지 연구가 확장되고 있다. 본 논문의 두 번째 연구인 video editing에서는 이미지와는 다른 비디오만의 특징인 motion 정보를 활용하여 비디오를 편집하는 방법을 제안한다. 기존의 연구들이 이미지를 기반으로 학습된 모델로부터 생성된 attention map을 비디오에 적용할 때 움직임에 대한 정보가 담긴 prompt의 attention map을 정확히 추정하지 못한다는 문제점이 있다. 이러한 문제들을 비디오만의 특성인 motion 정보를 활용하여 해결하고 더 나아가 추가적인 외부 딥러닝 모델 없이 motion 정보만을 추정하여 비디오 내부에서 나타나는 움직임의 방향을 특정하여 편집할 수 있는 방법을 제안한다.

앞서 설명한 두 framework를 통해 본 논문에서는 생성형 AI가 image outpainting과 video editing task에서도 좋은 성능을 나타내면서 적용할 수 있음을 두 연구에 대한 실험결과를 통해 보인다. Image outpainting에 대한 연구의 실험 결과는 기존 모델 성능 대비 제안하는 framework를 통해 생성된 output이 더 우수함을 보였고, video editing에 대한 실험 결과는 기존 모델에 제안하는 framework를 적용했을 때, 더 나은 output을 생성하는 것을 확인했다. 추후 생성형 AI를 image outpainting과 video editing 분야에 함께 적용할 수 있는 방법을 연구하고자 한다.*표시는 필수 입력사항입니다.

| 전화번호 |

|---|

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 번호 | 발행일자 | 권호명 | 제본정보 | 자료실 | 원문 | 신청 페이지 |

|---|

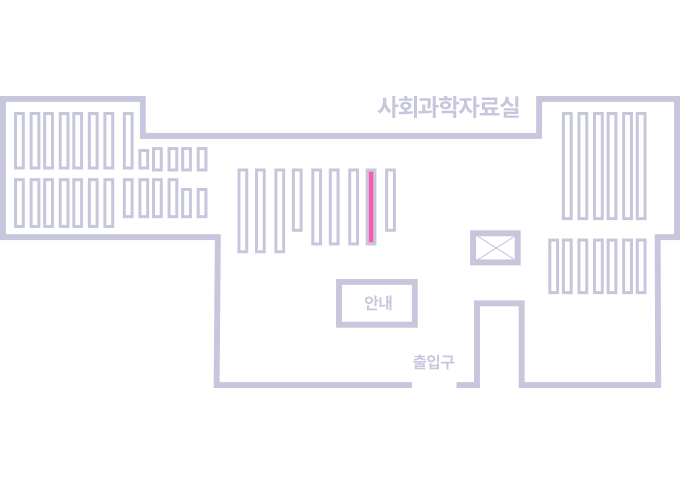

도서위치안내: / 서가번호:

우편복사 목록담기를 완료하였습니다.

*표시는 필수 입력사항입니다.

저장 되었습니다.