권호기사보기

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 대표형(전거형, Authority) | 생물정보 | 이형(異形, Variant) | 소속 | 직위 | 직업 | 활동분야 | 주기 | 서지 | |

|---|---|---|---|---|---|---|---|---|---|

| 연구/단체명을 입력해주세요. | |||||||||

|

|

|

|

|

|

* 주제를 선택하시면 검색 상세로 이동합니다.

표제지

목차

논문요약 10

제1장 서론 12

제2장 연구배경 15

1. 순차적 추천 시스템 15

2. 트랜스포머 기반 순차적 추천 모델 17

3. 선행 실험 19

제3장 실험환경 21

1. 데이터셋 21

2. 평가 지표 및 평가 프로토콜 22

3. 구현 세부 정보 23

제4장 실험결과 24

1. SASRec과 BERT4Rec의 성능 비교 24

2. 데이터셋 특성에 따른 성능 분석 28

1) 사용자-항목 상호작용 수 28

2) 사용자 시퀀스 길이 35

3) 목표 항목 인기도 36

제5장 통합된 트랜스포머 기반 추천 모델 38

1. BERT4Rec의 성능 저하 원인 38

2. SASRec과 BERT4Rec의 통합 41

제6장 결론 45

참고 문헌 46

ABSTRACT 52

그림 1. 트랜스포머 기반 순차적 추천 모델들의 구조 비교 17

그림 2. ML-1M과 Beauty 데이터셋에서 두 모델의 학습 손실 변화 추이 19

그림 3. 데이터셋 그룹에 따른 성능 경향성 27

그림 4. ML-1M 데이터에서 사용자-항목 상호작용 수에 따른 SASRec과 BERT4Rec의 성능 변화. X축은 전체 사용자-항목 상호작용에서 학습에 활용한... 28

그림 5. ML-1M 과 Beauty 데이터셋에 대한BERT4Rec 어텐션 가중치. 왼쪽 상단은 첫 번째 층의 첫 번째 헤드, 오른쪽 상단은 첫 번째 층의 두 번째 헤드를 의미하며, 왼쪽... 30

그림 6. Beauty와 Toys 데이터에서 학습 단계를 늘린 BERT4Rec 성능 비교. BERT4Rec이 기존 학습 단계로 학습한 모델이며 BERT4Rec+는 기존 대비 5배 긴... 34

그림 7. ML-1M과 Beauty 데이터에 대한 최대 시퀀스 길이에 따른 SASRec과 BERT4Rec의 성능 변화. 35

그림 8. Beauty 데이터셋에서 마지막 항목 예측 비율에 따른 성능 변화. X축은 전체 학습 데이터 중 마지막 항목 마스킹을 수행하는 비율을 의미한다. 40

그림 9. 통합된 트랜스포머 기반 순차적 추천 모델. BERT4Rec의 트랜스포머 인코더와 SASRec의 트랜스포머 디코더를 통합한 트랜스포머 인코더-디코더 구조의... 41

그림 10. ML-1M과 Beauty 데이터셋에서 SASRec, BERT4Rec, 통합된 모델의 성능 비교. SASRec+BERT4Rec은 SASRec의 트랜스포머 디코더와 BERT4Rec의... 43

*표시는 필수 입력사항입니다.

| *전화번호 | ※ '-' 없이 휴대폰번호를 입력하세요 |

|---|

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 번호 | 발행일자 | 권호명 | 제본정보 | 자료실 | 원문 | 신청 페이지 |

|---|

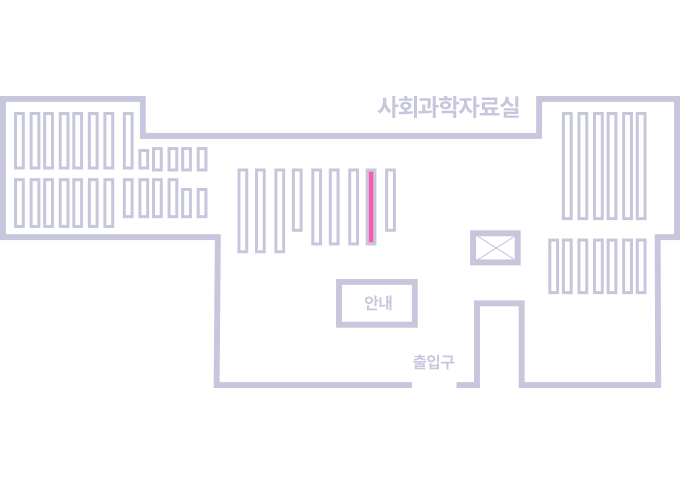

도서위치안내: / 서가번호:

우편복사 목록담기를 완료하였습니다.

*표시는 필수 입력사항입니다.

저장 되었습니다.