권호기사보기

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 대표형(전거형, Authority) | 생물정보 | 이형(異形, Variant) | 소속 | 직위 | 직업 | 활동분야 | 주기 | 서지 | |

|---|---|---|---|---|---|---|---|---|---|

| 연구/단체명을 입력해주세요. | |||||||||

|

|

|

|

|

|

* 주제를 선택하시면 검색 상세로 이동합니다.

| 기사명 | 저자명 | 페이지 | 원문 | 목차 |

|---|---|---|---|---|

| 물 표면 시뮬레이션을 위한 보존적 USCIP법 = A conservative USCIP simulation method for shallow water | 전세종, 송오영 | p.21-30 |

|

|

| Atrous Convolution과 Grad-CAM을 통한 손 끝 탐지 = Fingertip detection through atrous convolution and Grad-CAM | 노대철, 김태영 | p.11-20 |

|

|

| 적대적생성신경망을 이용한 연안 파랑 비디오 영상에서의 빗방울 제거 및 배경 정보 복원 = Raindrop removal and background information recovery in coastal wave video imagery using generative adversarial networks | 허동, 김재일, 김진아 | p.1-9 |

|

| 번호 | 참고문헌 | 국회도서관 소장유무 |

|---|---|---|

| 1 | D. Lowe, “Distinctive image features from scale-invariant keypoints,” IJCV, 60(2): pp. 91-110, 2004. | 미소장 |

| 2 | P. Viola, and M. Jones, “Rapid object detection using a boosted cascade of simple features,” CVPR, pp. 511-518, 2004. | 미소장 |

| 3 | G. Csurka, C. Dance, L. Fan, J. Willamowski, and C. Bray, “Visual categorization with bags of keypoints,” Workshop on statistical learning in computer vision, ECCV, pp. 1-22, 2004. | 미소장 |

| 4 | A. Krizhevsky, I. Sutskever, and G. E. Hinton, “ ImageNet classification with deep convolutional neural networks,” Advances in neural information processing systems, pp. 1097-1105, 2012. | 미소장 |

| 5 | K. He, X. Zhang, S. Ren, and J. Sun, “Deep residual learning for image recognition,” Proceedings of the IEEE conference on computer vision and pattern recognition, pp. 770-778, 2016. | 미소장 |

| 6 | R. Girshick, J. Donahue, T. Darrell, and J. Malik, “Rich feature hierarchies for accurate object detection and semantic segmentation,” Proceedings of the IEEE conference on computer vision and pattern recognition, pp.580-587, 2014. | 미소장 |

| 7 | R. Girshick, “Fast R-CNN,” Proceedings of the IEEE international conference on computer vision, pp.1440-1448, 2015. | 미소장 |

| 8 | C. Farabet, C. Couprie, L. Najman, and Y. LeCun, “Learning hierarchical features for scene labeling,” IEEE transactions on pattern analysis and machine intelligence, pp. 1915-1929, 2012. | 미소장 |

| 9 | L. C. Chen, G. Papandreou, I. Kokkinos, K. Murphy, and A. L. Yuille, “Semantic image segmentation with deep convolutional nets and fully connected CRFs,” arXiv preprint arXiv: 1412.7062, 2014. | 미소장 |

| 10 | S. Ren, K. He, R. Girshick, and J. Sun, “Faster R-CNN: Towards real-time object detection with region proposal networks,” Advances in neural information processing systems, pp. 91-99, 2015. | 미소장 |

| 11 | J. Redmon, S. Divvala, R. Girshick, and A. Farhadi, “You Only Look Once: Unified, real-time object detection,” Proceedings of the IEEE conference on computer vision and pattern recognition, pp. 779-788, 2016. | 미소장 |

| 12 | R. R. Selvaraju, M. Cogswell, A. Das, R. Vedantam, D. Parikh, and D. Batra, “Grad-CAM: Visual explanations from deep networks via gradient-based localization,” Proeceedings of the IEEE international conference on computer vision, pp. 618-626, 2017. | 미소장 |

| 13 | L. C. Chen, G. Papandreou, I. Kokkinos, K. Murphy, and A. L. Yuille, “Deeplab: Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs,” IEEE transactions on pattern analysis and machine intelligence, 40(4): pp. 834-848, 2017. | 미소장 |

| 14 | B. Zhou, A. Khosla, A. Lapedriza, A. Oliva, and A. Torralba, “Learning deep features for discriminative localization,” Proceedings of the IEEE conference on computer vision and pattern recognition, pp. 2921-2929, 2016. | 미소장 |

| 15 | M. Lin, Q. Chen, and S. Yan, “Network in network,” arXiv preprint arXiv:1312.4400, 2013. | 미소장 |

| 16 | V. Nair, G. E. Hinton, “Rectified linear units improve restricted boltzmann machines,” Proceedings of the 27th international conference on machine learning (ICML-10), pp. 807-814, 2010. | 미소장 |

| 17 | J. Hosang, R. Benenson, and B. Schiele, “Learning non-maximum suppression,” Proceedings of the IEEE conference on computer vision and pattern recognition, pp. 4507-4515, 2017. | 미소장 |

| 18 | K. Simonyan, and A. Zisserman, “Very deep convolutional networks for large-scale image recognition,” arXiv preprint arXiv: 1409.1556, 2014. | 미소장 |

| 19 | W. Liu, D. Anguelov, D. Erhan, C. Szegedy, S. Reed, C. Y. Fu, and A. C. Berg, “SSD: Single shot multibox detector,” European conference on computer vision, pp. 21-37, 2016. | 미소장 |

| 20 | A. Krizhevsky, and G. Hinton, “Learning multiple layers of features from tiny images,” Tech Report, 2009. | 미소장 |

*표시는 필수 입력사항입니다.

| 전화번호 |

|---|

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 번호 | 발행일자 | 권호명 | 제본정보 | 자료실 | 원문 | 신청 페이지 |

|---|

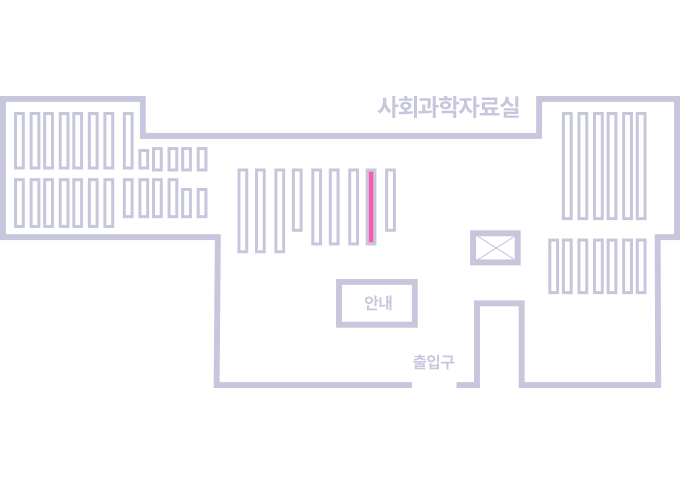

도서위치안내: 정기간행물실(524호) / 서가번호: 국내10

2021년 이전 정기간행물은 온라인 신청(원문 구축 자료는 원문 이용)

우편복사 목록담기를 완료하였습니다.

*표시는 필수 입력사항입니다.

저장 되었습니다.