권호기사보기

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 대표형(전거형, Authority) | 생물정보 | 이형(異形, Variant) | 소속 | 직위 | 직업 | 활동분야 | 주기 | 서지 | |

|---|---|---|---|---|---|---|---|---|---|

| 연구/단체명을 입력해주세요. | |||||||||

|

|

|

|

|

|

* 주제를 선택하시면 검색 상세로 이동합니다.

목차 1

다목적 바퀴형 이동로봇 플랫폼 개발 및 영상기반 비정형 환경 자율주행 기술 연구 = Visual navigation in unstructured environments and the development of a multi-purpose mobile robot platform / 심현재 ; 김여호수아 ; 홍준기 ; 남승원 ; 김용희 ; 허재 ; 황환철 ; 김광기 1

Abstract 1

I. INTRODUCTION 1

II. MUETI-PURPOSE HARD硏ARE PLATFORM 3

III. SEGMENTATION-BASED VISION CONTROL 4

1. Semantic Image Segmentation 4

2. Direct Vision-based Control 4

IV. VISUAL NAVIGATION WITH DEPTH-COMBINED TERRAIN TRAVERSABILITY ANALYSIS 5

1. Outdoor Terrain Segmentation 5

2. Road Segmentation using Depth Point Cloud 6

3. Visual Navigation 6

V. EXPERIMENTAL RESULTS 7

1. Experimental Setup 7

2. Results 8

VI. CONCLUSION 9

REFERENCES 9

[저자소개] 10

| 번호 | 참고문헌 | 국회도서관 소장유무 |

|---|---|---|

| 1 | L. E. Parker, “Current state of the art in distributed autonomous mobile robotics,” Distributed Autonomous Robotic Systems, vol. 4, pp. 3–12, 2000. | 미소장 |

| 2 | B.-S. Kim, J. H. Choi, C. Lee, and S. Oh, “Development and control of an autonomous user-tracking golf caddie robot,” Journal of Institute of Control, Robotics, and Systems (in Korean), vol. 28, no. 2, pp. 102–108, 2022. | 미소장 |

| 3 | C. Kim, B. Kim, and B. Lee, “Structural safety evaluation of tracking driving golf caddy robot,” Proceedings of the Korean Society of Mechanical Engineers (KSME) Conference (in Korean), pp. 161–161, 2022. | 미소장 |

| 4 | M. Chghaf, S. Rodriguez, and A. E. Ouardi, “Camera, lidar and multi-modal slam systems for autonomous ground vehicles: a survey,” Journal of Intelligent & Robotic Systems, vol. 105, no. 1, p. 2, 2022. | 미소장 |

| 5 | J. S. Berrio, M. Shan, S. Worrall, and E. Nebot, “Camera-lidar integration: Probabilistic sensor fusion for semantic mapping,” IEEE Transactions on Intelligent Transportation Systems, vol. 23, no. 7, pp. 7637–7652, 2021. https://ieeexplore.ieee.org/abstract/document/4049251 | 미소장 |

| 6 | C. Debeunne and D. Vivet, “A review of visual-lidar fusion based simultaneous localization and mapping,” Sensors, vol. 20, no. 7, p. 2068, 2020. | 미소장 |

| 7 | J. Cheng, L. Zhang, Q. Chen, X. Hu, and J. Cai, “A review of visual slam methods for autonomous driving vehicles,” Engineering Applications of Artificial Intelligence, vol. 114, p. 104992, 2022. | 미소장 |

| 8 | W. Lan, J. Dang, Y. Wang, and S. Wang, “Pedestrian detection based on yolo network model,” IEEE International Conference on Mechatronics and Automation (ICMA), pp. 1547–1551, 2018. | 미소장 |

| 9 | J. Tao, H. Wang, X. Zhang, X. Li, and H. Yang, “An object detection system based on yolo in traffic scene,” 6th International Conference on Computer Science and Network Technology (ICCSNT), pp. 315–319, 2017. | 미소장 |

| 10 | S. Shinde, A. Kothari, and V. Gupta, “Yolo based human action recognition and localization,” Procedia Computer Science, vol. 133, pp. 831–838, 2018. | 미소장 |

| 11 | O. Ronneberger, P. Fischer, and T. Brox, “U-Net: Convolutional networks for biomedical image segmentation,” Medical Image Computing and Computer-assisted Intervention–MICCAI 2015: 18th International Conference, Part III 18, Munich, Germany, pp. 234–241, Oct. 2015. | 미소장 |

| 12 | F. Milletari, N. Navab, and S.-A. Ahmadi, “V-Net: Fully convolutional neural networks for volumetric medical image segmentation,” Fourth International Conference on 3D Vision (3DV), pp. 565–571, 2016. | 미소장 |

| 13 | L.-C. Chen, G. Papandreou, I. Kokkinos, K. Murphy, and A. L. Yuille, “DeepLab: Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs,” IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 40, no. 4, pp. 834–848, 2017. | 미소장 |

| 14 | J. Long, E. Shelhamer, and T. Darrell, “Fully convolutional networks for semantic segmentation,” Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pp. 3431–3440, 2015. | 미소장 |

| 15 | H. Zhao, J. Shi, X. Qi, X. Wang, and J. Jia, “Pyramid scene parsing network,” in Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017, pp. 2881–2890. | 미소장 |

| 16 | Z. Zhigang, L. Huan, D. Pengcheng, Z. Guangbing, W. Nan, and Z. Wei-Kun, “Vehicle target detection based on R-FCN,” Chinese Control and Decision Conference (CCDC), pp. 5739–5743, 2018. | 미소장 |

| 17 | D. K. Dewangan and S. P. Sahu, “Road detection using semantic segmentation-based convolutional neural network for intelligent vehicle system,” Data Engineering and Communication Technology: Proceedings of ICDECT 2020, pp. 629–637, 2020. | 미소장 |

| 18 | Y. Zhang, H. Chen, Y. He, M. Ye, X. Cai, and D. Zhang, “Road segmentation for all-day outdoor robot navigation,” Neurocomputing, vol. 314, pp. 316–325, 2018. | 미소장 |

| 19 | D. Wicker, M. M. Rizki, and L. A. Tamburino, “E-Net: Evolutionary neural network synthesis,” Neurocomputing, vol. 42, no. 1-4, pp. 171–196, 2002. | 미소장 |

| 20 | H. Zhao, X. Qi, X. Shen, J. Shi, and J. Jia, “ICNet for real-time semantic segmentation on high-resolution images,” Proceedings of the European Conference on Computer Vision (ECCV), pp. 405–420, 2018. | 미소장 |

| 21 | Q. Yan, S. Li, C. Liu, M. Liu, and Q. Chen, “Roboseg: Real-time semantic segmentation on computationally constrained robots,” IEEE Transactions on Systems, Man, and Cybernetics: Systems, vol.52, no.3, pp. 1567–1577, 2020. | 미소장 |

| 22 | J.-H. Kim and K-K. K. Kim, “Vision-based markerless robot-to-robot relative pose estimation using RGB-D data,” Journal of Institute of Control, Robotics, and Systems (in Korean), vol. 29, no. 10, pp. 495–503, 2023. | 미소장 |

| 23 | D. H. Dos Reis, D. Welfer, M. A. De Souza Leite Cuadros, and D. F. T. Gamarra, “Mobile robot navigation using an object recognition software with RGBD images and the YOLO algorithm,” Applied Artificial Intelligence, vol. 33, no. 14, pp. 1290–1305, 2019. | 미소장 |

| 24 | Z. Zhang and M. Sabuncu, “Generalized cross entropy loss for training deep neural networks with noisy labels,” Advances in Neural Information Processing Systems, vol. 31, 2018. | 미소장 |

| 25 | K. M. Dawson-Howe and D. Vernon, “Simple pinhole camera calibration,” International Journal of Imaging Systems and Technology, vol. 5, no. 1, pp. 1–6, 1994. | 미소장 |

| 26 | P. I Corke and S. A. Hutchinson, “A new hybrid image-based visual servo control scheme,” Proceedings of the 39th IEIE Conference on Decision and Control (Cat. No. 00CH37187), vol. 3. IEEE, 2000. pp. 2521–2526. | 미소장 |

| 27 | S. C. Yurtkulu, Y. H. Şahin, and G. Unal, “Semantic segmentation with extended DeepLabv3 architecture,” 27th Signal Processing and Communications Applications Conference (SIU), pp. 1–4, 2019. | 미소장 |

| 28 | T. Guan, D. Kothandaraman, R. Chandra, A. J. Sathyamoorthy, K. Weerakoon, and D. Manocha, “GA-Nav: Efficient terrain segmentation for robot navigation in unstructured outdoor environments,” IEEE Robotics and Automation Letters, vol. 7, no. 3, pp. 8138–8145, 2022. | 미소장 |

| 29 | U. Ruby and V. Yendapalli, “Binary cross entropy with deep learning technique for image classification,” Int. J. Adv. Trends Comput. Sci. Eng., vol. 9, no. 10, 2020. | 미소장 |

| 30 | M. Wigness, S. Eum, J. G. Rogers, D. Han, and H. Kwon, “A rugd dataset for autonomous navigation and visual perception in unstructured outdoor environments,” IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). IEEE, pp. 5000–5007, 2019. | 미소장 |

*표시는 필수 입력사항입니다.

| 전화번호 |

|---|

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 번호 | 발행일자 | 권호명 | 제본정보 | 자료실 | 원문 | 신청 페이지 |

|---|

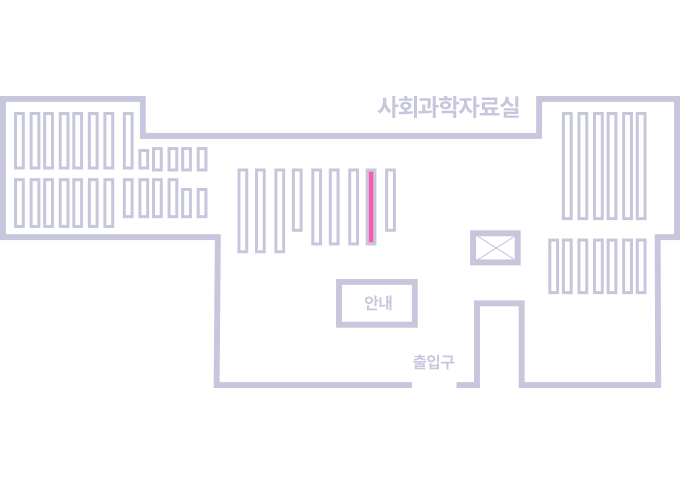

도서위치안내: 정기간행물실(524호) / 서가번호: 국내09

2021년 이전 정기간행물은 온라인 신청(원문 구축 자료는 원문 이용)

우편복사 목록담기를 완료하였습니다.

*표시는 필수 입력사항입니다.

저장 되었습니다.